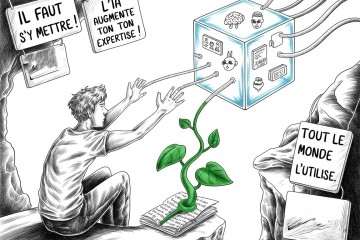

L’intelligence artificielle s’intègre dans nos activités quotidiennes. À l'ère de la taylorisation rampante dans la zone «col blanc» de l’entreprise, les métiers de la donnée et de la connaissance se polarisent : exécution automatisée d›un côté, compétences de cadrage vitales de l›autre.

Netsources est une boussole dans cette mutation. Nous identifions les compétences qui résistent à l’automatisation, celles qui maintiennent l’humain aux commandes. Car la vraie question n’est pas «que peut faire l’IA ?», mais « que devons-nous savoir faire pour rester pilotes ? »

Sans questions, pas de valeur

Comme Christian Vigne l’avait souligné fin 2024 dans sa chronique «Mon premier paper : Answers in abundance, questions in scarcity», que nous publions ici pour la première fois : le problème n’est pas la machine avec son offre infinie de réponses, mais la question, souvent rare et mal formulée.