Tel est le titre de la matinée d’étude organisée et animée conjointement par l’ADBS et le CNAM/INTD le 2 avril dernier. Invitée à y cadrer le sujet (polysémique) de la veille collaborative, je propose ici une restitution sélective des interventions entendues ce jour-là, complétée par ma propre expérience de praticienne et de consultante amenée à accompagner ou observer la mise en place de tels dispositifs depuis une quinzaine d’années.

Le sujet de la veille collaborative revient à peu près tous les dix à quinze ans justement sur la table : il suscite l’intérêt à un rythme régulier, porteur qu’il est d’un idéal exigeant et de la promesse de synergies et de « désilotage » dans les organisations, mais il faut bien reconnaître que ce type de démarche rencontre plus souvent ses limites que son public, comme l’a énoncé avec justesse Thomas Grignon (1) dans son discours introductif.

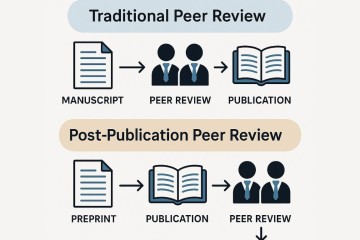

Le premier enseignement de cette matinée est que les professionnels de l’information ont une définition extensive de la veille collaborative, dont ils font une activité de surveillance mobilisant un collectif. Cette définition large n’est pas la mienne. Que la veille soit une activité requérant plusieurs forces vives est une évidence. La qualifier de collaborative introduit à mon sens le fait de distribuer l’effort de veille auprès d’un ensemble de contributeurs au nombre desquels figurent nécessairement des acteurs métiers, habituellement simples destinataires de la veille, désormais contributeurs actifs.

Reconnaissons qu’il n’est pas aisé de proposer de la veille collaborative une définition consensuelle compte tenu de la diversité des formes qu’elle peut prendre dans des configurations très variables, des « 1001 visages » qu’elle offre.

Sa mise en place, pour commencer, n’obéit pas aux mêmes éléments déclencheurs : si le défaut de ressources est souvent premier (une équipe étriquée, ne pouvant à elle seule pourvoir à l’ensemble des besoins en information, est tentée d’élargir le nombre de ses contributeurs), d’autres motifs relèvent du constat de pratiques de veille essentiellement individuelles, artisanales et informelles, d’un sentiment de solitude et de cloisonnement (avivant le risque de doublons et d’incohérences dans le recueil et l’analyse des informations), d’une volonté d’autonomie des bénéficiaires de la veille (désireux d’apporter leur pierre à l’édifice), etc. Le motif déclencheur peut aussi être une injonction managériale, une direction faisant parfois le pari qu’un tel dispositif contribuera à favoriser la collaboration entre des services et métiers se rencontrant peu malgré l’intérêt qu’ils auraient à travailler ensemble.

Pour autant, la veille collaborative ne postule pas forcément de la transversalité autour de sujets fédérateurs à fort enjeu (la compréhension d’un marché, la détection d’évolutions sociétales…) ou même des zones d’adhérence dans les sujets traités : elle peut concerner des sujets ponctuels qui n’intéresseront qu’un groupe limité d’acteurs.

Un dispositif de veille collaborative ne se reconnaît pas davantage à un mode d’organisation particulier. Il peut s’appuyer sur une communauté constituée, dont les membres se rencontrent à échéances régulières, pilotée par une équipe ou un community manager. Il peut aussi consister en des rendez-vous ritualisés en petits comités, dont l’objet est de coproduire (ou pas) des livrables. Il peut encore se traduire par la sollicitation ponctuelle d’experts qui ne sont jamais les mêmes.

Au CETIM (2), l’équipe de 8 veilleurs emmenée par Laurent Couvé (3) implique une quarantaine des 700 experts techniques (ingénieurs, techniciens supérieurs, docteurs, répartis aux quatre coins de la France) dans la couverture des salons, congrès et autres journées techniques (4) : charge à eux de rédiger un compte-rendu de l’événement relevant de la spécialité qui les concerne (une note de veille en contrepartie du financement de leur déplacement), à l’attention des industriels cotisants qui ne disposent pas des ressources suffisantes pour effectuer eux-mêmes ce travail de détection des sujets émergents. La restitution des enseignements du salon auprès des industriels lors d’un webinaire représente pour les experts du CETIM une occasion précieuse de se faire connaître et de « décrocher » potentiellement des clients, tandis que la coopération avec les experts a pour retombée indirecte des demandes de recherches bibliographiques plus étoffées auprès de l’équipe de veille.