L’Intelligence artificielle générative investit toujours plus de secteurs. Celui des brevets n’y échappe pas.

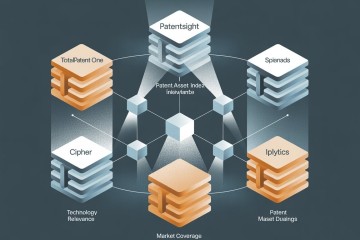

L’annonce inattendue par PERPLEXITY d’une recherche spécifique brevet nous a incité à explorer le paysage. Nous pensions que cela serait rapide avec une offre limitée. En réalité, nous avons constaté l’inverse : il existe plus d’une quinzaine d’outils et de services à travers le monde qui proposent de réaliser des recherches de brevets en ligne, assistées par l’intelligence artificielle censée les rendre plus efficaces.

Ces outils offrent la possibilité de sélectionner réellement des documents pertinents en réponse à une requête en langage libre, constituant ainsi un état de l’art partiel. Ils ne se limitent pas à l’établissement d’un classement par pertinence sur la base d’une recherche booléenne classique, comme le propose PubMed, ni à l’extraction automatisée de codes CPC à partir d’un document, telle que réalisée par Espacenet.