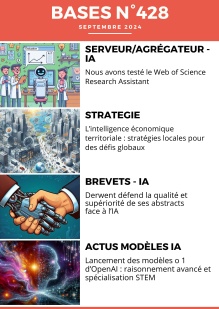

Dans ce numéro, nous publions la première partie d’un dossier complet consacré au prompt engineering. La seconde partie paraîtra dans le prochain numéro de NETSOURCES

Ce dossier a pour objectif de vous accompagner dans la maîtrise du prompt engineering, discipline clé pour exploiter pleinement le potentiel des modèles de langage.

De la compréhension des mécanismes fondamentaux aux techniques les plus avancées, , ces deux articles constituent un guide complet pour maîtriser l’art du prompt engineering et tirer le meilleur parti des modèles de langage actuels et futurs.

Premier article : les fondamentaux du prompt engineering

Ce premier article récapitule les principes essentiels pour optimiser la formulation des prompts:

- Mécanismes internes des LLM : Rappel des processus clés - tokenisation (découpage du texte), embeddings vectoriels (représentation numérique) et architecture transformer (mécanismes d’attention) - pour comprendre comment les modèles traitent les prompts).

- Frameworks de structuration : Présentation de méthodologies structurantes combinant contexte, rôle et format de sortie, illustrées par des exemples concrets d’application.

- Techniques avancées : Exploration de méthodes sophistiquées comme les chaînes de pensées, ainsi que des techniques parfois méconnues comme l’utilisation de délimiteurs.

- Stratégie de longueur : Faut-il privilégier un prompt long et complet («méga-prompt») ou procéder par itérations successives ? La longueur optimale du prompt est une question cruciale.

-

Vous êtes ici :

- Accueil

- Tag : méthodologie

Tag: méthodologie

Comment accéder à 4 millions de thèses européennes en 2025 (sans perdre des heures)

DART-Europe a fermé. EThOS est hors service. Global ETD Search de NDLTD est indisponible.

Trois piliers de l’accès aux thèses européennes ont disparu… mais la recherche continue.

Le nouveau Guide des thèses européennes 2025, conçu par l’équipe de BASES (votre référence en information spécialisée depuis 1985), devient l’outil incontournable pour accéder à plus de 4 millions de thèses à travers 25 pays.

Un contexte bouleversé

- Février 2025 : fermeture définitive de DART-Europe (1 million de thèses, 29 pays).

- Depuis 2023 : EThOS (Royaume-Uni) hors service après cyberattaque.

- Depuis des mois : Global ETD Search (NDLTD) indisponible.

👉 Résultat : les chercheurs et documentalistes se retrouvent sans passerelle centralisée pour accéder aux thèses européennes.

Le prompt, un art pour la veille stratégique et la recherche d’information (1ere partie)

Crise de reproductibilité : quand la science peine à confirmer ses propres résultats

Un constat alarmant sur les méthodes de recherche

Un article publié en décembre 2021 a provoqué une onde de choc dans la communauté scientifique (1). Consulté plus de 20 400 fois, téléchargé près de 2 000 fois et ayant fait l’objet de 141 citations à ce jour, cette étude révèle un problème fondamental dans la recherche scientifique.

Les chercheurs ont tenté de reproduire 193 expériences décrites dans 53 articles à fort impact, dont les protocoles et plans d’analyse avaient été validés par des pairs avant leur publication. Le résultat est préoccupant : seules 50 expériences (26 %) issues de 23 articles (43 %) ont pu être reproduites. Plus troublant encore, 32 % des auteurs contactés ont refusé de répondre ou sont restés silencieux face aux demandes de précisions.

Comment se saisir avec pertinence de l’information scientifique lorsqu’on n’est pas scientifique ?

Pendant assez longtemps, la veille business et la veille scientifique et technique ont constitué des champs tout à fait distincts avec des compétences et ressources spécialisées bien définies pour les piloter, ainsi que des objectifs, des méthodes, des outils et des sources propres.

Puis la mise en place de plus en plus courante de veilles dites « innovation » a commencé à brouiller les frontières, mêlant informations concurrentielles et technologiques, et l’on constate que les spécialistes de la veille au sein des départements marketing et R&D de grands groupes travaillent étroitement ensemble pour fournir leurs analyses stratégiques au top management.

La veille IST a longtemps nécessité un véritable background scientifique et technique dans un domaine spécifique, quel qu’il soit (matériaux, énergie, agro-alimentaire, etc.), pour pouvoir exercer ce rôle efficacement. Pourtant, comprendre non seulement la pertinence, mais aussi l’apport de certains travaux scientifiques ou d’articles techniques n’est plus mission impossible pour celui qui n’est pas du sérail, et ce grâce au développement récent des outils d’intelligence artificielle qui changent la donne.

Bien sûr, un veilleur « généraliste » ne pourra jamais se hisser au niveau d'expertise d’un ingénieur spécialiste, mais l’IA va lui permettre en revanche d’élever sa compréhension des documents sans avoir de bagage spécifique et sans connaître tout le vocabulaire scientifique et technique spécialisé.

Faut-il optimiser ses prompts en fonction de chaque modèle d’IA ?

À l’arrivée de ChatGPT, nous avons vu fleurir sur le web et les réseaux sociaux une quantité de conseils sur l’art subtil de la formulation des prompts. On a vu également émerger une multitude d’outils et de bibliothèques de prompts prêts à l’emploi, souvent payants, adaptés à divers secteurs et types de questions (cf. FOCUS IA : maîtriser et gérer ses prompts, Bases N° 421- janvier 2024). Cette révolution IA a même donné naissance à un nouveau métier : le prompt engineering, qui semble se professionnaliser de plus en plus.

Rappelons au passage qu’un prompt (ensemble d’instructions ou encore d’invites) est adressé à un modèle de langage (LLM) via une interface utilisateur, qui peut prendre la forme d’un chatbot (interface conversationnelle) pour générer des réponses ou des contenus spécifiques. Par exemple, Open AI a développé le modèle GPT (avec ses déjà nombreuses versions) et a mis à disposition des utilisateurs le chatbot ChatGPT.

La question de l’universalité des prompts

Ces conseils et outils se concentrent principalement autour de ChatGPT, ce qui ne surprend pas au regard de la large et rapide démocratisation de l’IA générative qu’OpenAI a su orchestrer : il était urgent de fournir un « mode d’emploi » pour utiliser efficacement ce chatbot.

Cependant, une question fondamentale demeure : peut-on utiliser les mêmes prompts pour tous les modèles d’IA établis sur le marché (outre GPT : Gemini, Claude, Mistral, Llama principalement) ? Par exemple, Claude répond-il de manière aussi satisfaisante à un prompt conçu pour ChatGPT ?

Perplexity, le « couteau suisse de la découverte d’informations et de la curiosité »

Perplexity se définit comme un «moteur de réponses» innovant, combinant les fonctionnalités d’un moteur de recherche traditionnel avec celles d’un agent conversationnel alimenté par l’IA : une sorte d’hybride entre ChatGPT et Google Search.

Son ambition affichée est de concurrencer Google sur le marché de la recherche en ligne, en proposant une approche radicalement différente : plutôt que de fournir une simple liste de liens, Perplexity génère des réponses textuelles rédigées en s’appuyant sur des sources d’information récentes, variées et toujours indiquées en référence par l’outil.

La start-up californienne fondée en 2022 par un ancien d’Open AI, a rapidement attiré l’attention des investisseurs, atteignant une valorisation d’un milliard de dollars en 2024.

Le nom «Perplexity AI» fait référence à la notion de perplexité en théorie de l’information, qui mesure l’incertitude, mais il est utilisé ici de manière inverse. L’objectif de Perplexity AI est de réduire l’incertitude (ou la perplexité) des utilisateurs en fournissant des réponses claires et précises, transformant ainsi la haute perplexité en basse perplexité dans le domaine de la recherche d’information.

Fonctionnement et accès à Perplexity

Pour fonctionner, Perplexity extrait les données d’internet au moment où la question lui est posée, de sorte que les réponses sont réputées être toujours à jour. Il s’appuie ensuite sur plusieurs modèles de langage, le sien propre mais aussi celui d’OpenAI, le modèle open source Llama de Meta ou encore Claude 3, pour produire ses réponses. De plus, il propose des questions connexes à la requête initiale (rappelant un peu les requêtes suggérées de Google), permettant ainsi d’affiner progressivement la recherche.

L’accès peut se faire sans obligation de créer un compte, via le site web de l’application ou une application mobile, avec fonction de recherche vocale disponible sur iPhone. Il existe enfin une extension Chrome qui permet d’y accéder à partir de n’importe quelle page web, de lui faire résumer la page ou répondre à des questions sur ce qu’elle contient.

ADAY offre désormais la possibilité de combiner les étapes de recherche sur sa nouvelle plateforme

La possibilité de combiner les étapes de recherche est un outil très puissant, très utile pour des recherches complexes.

Cette fonctionnalité, longtemps et toujours présente sur les serveurs traditionnels, est aujourd’hui peu courante, voire inexistante, chez les agrégateurs de presse.

On peut certes toujours y utiliser parenthèses et opérateurs pour combiner différents concepts, mais cela s’avère rapidement compliqué.

Il est beaucoup plus simple, élégant et performant d’utiliser la combinaison d’étapes.

Bonnes pratiques pour systématiser la surveillance de vos concurrents

Une grande partie de la veille concurrentielle repose sur une surveillance de la presse, du web ouvert et des réseaux sociaux. Mais comment s’y prendre de façon structurée et systématique sans être noyé sous l’information ? Cet article a pour objectif de rappeler aux professionnels tous les flux à identifier pour être sûrs de ne rien laisser passer tout en maîtrisant le volume à traiter.

La première étape consiste évidemment à répertorier la liste des concurrents à surveiller. Dès ce stade, prenez le temps d’associer à chaque concurrent une ou plusieurs zones géographiques.

Le jour où j’ai voulu mettre en place une veille collaborative

Mettre en place un projet de veille collaborative dans une entreprise où il n’existe pas de service veille et où les collaborateurs ont l’habitude de pratiquer une veille individuelle est un vrai challenge ! Retour sur mon expérience dans une PME, sur les succès, mais aussi les difficultés rencontrées.

De l’intérêt de mener l’enquête

Lorsque j’étais en charge de la Documentation d’un bureau d’études technique (130 personnes environ), j’ai tenté d’initier une démarche de veille collaborative avec mes collègues ingénieurs.

J’avais l’intuition que les ingénieurs faisaient de la veille dans leur coin et de mon côté, j’avais l’ambition de développer mon offre de service. Je réalisais jusque-là des activités documentaires traditionnelles (panorama de presse, gestion d’un portail documentaire…) et je souhaitais proposer un service de veille.

Avec l’accord d’un des membres du Comex auquel j’étais directement rattachée, j’ai mené une enquête quantitative auprès de l’ensemble de la société (Direction comprise) sur leurs pratiques informationnelles.

Adopter une logique de flux… plus facile à dire qu’à faire

Le numérique a bouleversé les modèles traditionnels de gestion de l’information. Longtemps cantonnés à une approche statique avec des informations stockées sur des supports inertes, les professionnels doivent désormais appréhender un flot continu et dynamique de données. Ce virage vers une « culture de flux » implique une profonde mutation des pratiques.

La nécessité de passer d’une culture de stock à une culture de flux pour les métiers de l’information n’est pas nouvelle, pourtant elle peine toujours à être pleinement embrassée - et pleinement organisée - dans la pratique professionnelle.

En 2013, déjà, Caroline Sauvajol-Rialland, dans son ouvrage « Infobésité, comprendre et maîtriser la déferlante d’informations » (Éditions Vuibert, p.136), précisait : « en situation de surcharge informationnelle, il ne s’agit surtout pas d’archiver pour archiver et de multiplier les copies inutiles, mais de passer d’une logique de stock à une logique de flux, de passer de l’individu, qui porte la connaissance née de l’information, au collectif, qui produit de l’efficacité au sein du collectif ».

Les périls et la puissance du NOT dans la stimulation des chatbots

Nous avons le plaisir d’accueillir dans nos colonnes Marydee Ojala, professionnelle de l’information américaine très connue. Elle est rédactrice en chef de la revue ONLINE SEARCHER.

Nous avons adapté pour BASES l’article de Marydee, précédemment publié dans sa version originale en anglais dans la section ONLINE SEARCHER du numéro 5, volume 44, paru en juin 2024 de la revue COMPUTERS IN LIBRARIES sous le titre « The perils and power of NOT in prompting Chatbots » dans la rubrique « Voices of the searchers »

La plupart des professionnels de l’information connaissent bien les commandes booléennes de base : AND, OR et NOT. Elles fonctionnent parfaitement pour la recherche dans les bases de données traditionnelles. Lorsque nous enseignons les techniques de recherche, nous nous appuyons sur des exemples et des diagrammes de Venn pour démontrer la puissance de la recherche booléenne. J’ai toujours pensé que nous devrions souligner les dangers de la commande NOT, en particulier dans les ressources en texte intégral proposant des documents volumineux.

Maîtriser l'Open Data et l'IA pour transformer et exploiter les données différemment

En France, pays champion européen de l’open data, on parle souvent des startups qui parviennent à exploiter des données accessibles en accès gratuit, pour en faire des services, avec parfois une option payante, à l’instar de Pappers ou Doctrine.

Depuis la démocratisation de l’IA amorcée il y a plus d’un an avec la mise à disposition au public de ChatGPT, suivie depuis par d’autres IA génératives et services afférents, comment le traitement des données ouvertes a-t-il évolué et surtout, est-il davantage accessible à un utilisateur sans formation technique particulière en amont ? Exploration, étape par étape, du traitement des données, de l’extraction à la publication.

Extraction facilitée

Première étape : la collecte des données. Celle-ci peut se faire de deux façons : en téléchargeant un dataset ou en procédant à l’extraction des données sur un document. C’est dans ce second cas que les outils IA interviennent. S’offrent alors deux possibilités d’extraction de données :

- Avec un outil IA où l’on importe un fichier de données.

- Avec un tableur habituel, auquel on ajoute un module IA.

Avec un outil IA

Les outils IA qui permettent d’importer gratuitement des documents à traiter ne prennent pas en charge les formats de bases de données, mais uniquement les formats textes et PDF. Dans ce cas, extraire les données d’un document pour les récupérer sous forme texte ou de tableau est un jeu d’enfant.

STN : Des stratégies astucieuses pour la recherche brevet

Après la période de vide laissé par le départ en retraite de Martine Michel, CAS (Chemical Abstracts Services qui gère STN en collaboration avec FIZ Karlsruhe) vient de recréer son équipe en charge de la France.

Cette nouvelle équipe a organisé une réunion en présentiel, ce qui n’était pas arrivé depuis fort longtemps.

Cette réunion était centrée sur la chimie et les brevets. Les autres banques de données présentes sur STN seront, quant à elles, évoquées lors d’une prochaine rencontre.

Cette réunion a été marquée par la présentation de nombreux exemples détaillés très intéressants concernant diverses problématiques. Ce fut l’occasion d’illustrer la puissance du langage de requête Messenger utilisé par STN dont la contrepartie est une certaine complexité qui n’a, cependant, rien d’insurmontable.

Médias et IA : ce que cela change pour la veille

Après les moteurs de recherche et les médias sociaux, l’IA générative redistribue de nouveau les cartes pour les médias d’information. Avec des impacts considérables sur la production, la diffusion et la monétisation du contenu. Comment les médias s’adaptent-ils et comment cela affecte-t-il l’activité de veille ? Petit tour des initiatives en cours.

Dans ses recherches, au cours de ses analyses ou de la réalisation de ses livrables, le professionnel de la veille est de plus en plus exposé, de façon plus ou moins subtile, à l’information en provenance des IA génératives.

Au départ, les réponses créées par les chatbots d’IA générative comme ChatGPT, Bard et quelques autres, lui ont offert un autre mode d’accès à l’information : un accès direct aux réponses, sans cliquer sur les sources. Et cet usage devrait perdurer si l’on en croit la prochaine version de Google, SGE, qui valorise les réponses générées par IA au détriment des résultats de recherche présentés sous forme de liens.

Impacts sur la recherche

Des médias moins visibles dans les résultats des moteurs de recherche

Mais le contenu généré par IA commence aussi à concurrencer les médias sous une autre forme : des sites entièrement créés par IA s’invitent en effet dans les résultats des moteurs de recherche. Leur contenu, écrit pour correspondre aux règles actuelles de SEO, serait même mieux référencé que celui des médias. Récemment, le service américain de notation de l’actualité NewsGuard a identifié près de 600 sites Web (ils étaient 49 en mai dernier) qui fonctionnent avec peu ou pas d’intervention humaine. Et un site généré par l’IA produit jusqu’à 1200 articles par jour, contre 100 pour Le Monde ou 250 pour le New York Times ! Certains sont même financés par la publicité.

Les médias ont donc raison de craindre une baisse de leur propre trafic, qui provient à plus de 90 % de Google. Pour la veille, cela signifie davantage de difficultés à trouver certains contenus en provenance de médias pertinents, soudainement noyés dans des pseudos sites d’actualités générés par l’IA, mais difficiles à identifier, car ils reprennent les codes graphiques des sites d’actualités. Ce qui nécessite donc davantage de rigueur encore en phase de sourcing.

Comment intégrer les brevets à sa veille concurrentielle ?

On oublie trop souvent que les brevets ont un intérêt pour la veille concurrentielle. Et pourtant, en savoir un peu plus sur la politique brevet d’une entreprise est souvent très utile : par exemple, S’il s’agit de l’un de vos concurrents, cela peut être intéressant de connaître les techniques sur lesquelles il dispose d’une capacité d’interdiction, Si c’est un potentiel partenaire, cela peut être très pertinent avant de signer un accord de collaboration de connaître son niveau de sensibilité à la propriété industrielle. Et s’il s’agit d’un des fournisseurs auprès duquel vous vous approvisionnez en composants indispensables, s’il dispose de brevets sur ces composants, cela peut vouloir dire que vous ne pourrez vous fournir ailleurs. Et cette liste est loin d’être exhaustive.

Alors comment collecter des informations sur la politique brevet d’un concurrent, d’un partenaire, d’un fournisseur…. sans se ruiner ? Et comment entrer et comprendre les bases du monde des brevets, qui peut paraître inaccessible aux non-initiés ?

Toutes les données brevet sont publiques, accessibles dans des bases de données dont beaucoup sont en accès libre, comme Espacenet ou Patentscope. Dans cet article, nous allons vous montrer comment les retrouver.

Pour cela nous partirons d’un exemple concret en nous intéressant à la politique brevet de Volocopter, une startup allemande conceptrice d’un taxi volant à propulsion électrique qu’elle ambitionne de faire voler à l’occasion des Jeux olympiques de Paris, à l’été 2024.

Comment utiliser l’information business et l’actualité pour enrichir sa veille brevet ?

Comme nous avons pu le voir dans l’article « Comment enrichir sa veille concurrentielle avec les brevets ? » de ce même numéro, l’information brevet a un rôle à jouer dans tous les types de veille mais l’inverse est aussi vrai. L’information non-brevet, comme l’information business, financière, presse, etc. a aussi un rôle à jouer pour enrichir et améliorer la veille brevet.

C’est ce que nous avons choisi d’explorer dans cet article en partant d’un exemple concret : analyser la politique brevet de Quobly, une start-up française dans le secteur de la recherche quantique qui a récemment fait parler d’elle avec l’entrée de BPI France dans son capital. Nous avons choisi de mener l’enquête uniquement avec des données en libre accès.

NB : Suivant de loin le sujet du quantique, nous savons que les acteurs américains et chinois du domaine y ont une politique brevet très active. Un rapport de Michel Kurek publié en 2020 a établi que sur la période 2010 - 2020 les acteurs chinois sont à l’origine de 5164 familles de brevets, les acteurs américains de 1990 familles, et les acteurs français d’un modeste chiffre de 126 familles.

Débuter avec les outils de recherche brevet

Quoi de mieux pour analyser une politique brevet que de commencer par une recherche dans les brevets. Nous avons utilisé ici l’outil Espacenet (pour savoir comment rechercher sur Espacenet, nous vous invitons à lire l’article « Comment enrichir sa veille concurrentielle avec les brevets ? » dans ce même numéro).

Comment utiliser Discord pour ses veilles et ses recherches ?

Avec la multiplication des médias sociaux et les changements récents au sein de X (ex-Twitter) qui conduisent à se poser sérieusement la question d’une alternative, les professionnels de la veille sont amenés à tester, maintenant plus que jamais, de nouveaux canaux pour surveiller (et diffuser) leurs informations.

L’une des plateformes où trouver de l’information de qualité, souvent de niche, est Discord. L’outil étant réservé au départ aux gamers et peu intuitif au premier abord dans une démarche de veille, beaucoup de professionnels n’ont sans doute pas encore osé franchir le pas. Pourtant, la qualité des communautés, du contenu et des relations entretenues sur cette plateforme, ainsi qu’une expérience plus saine pour notre santé mentale, garantie sans intrusion publicitaire ni surcharge algorithmique, valent la peine de fournir un effort supplémentaire. Mode d’emploi.

1) La première approche que l’on peut avoir de l’outil sur la page d’accueil de son site internet, avec ses avatars enfantins aux couleurs pétillantes, et ses catégories de contenu tournées vers les loisirs, est certes déconcertante.

Comment révolutionner sa propre veille métier via le concept de second cerveau ?

Dans le monde professionnel, chacun développe en continu les compétences utiles à l’exercice de son métier pour rester à la pointe et devenir d’une certaine façon « la meilleure version professionnelle de soi-même ».

L’une des manières d’y parvenir consiste à faire de la veille métier, c’est-à-dire à analyser les dernières tendances et dernières innovations techniques, s’approprier de nouvelles méthodologies et astuces ou encore être en phase avec les dernières évolutions du marché, ce qui dans le contexte actuel n’est pas une mince affaire.

Difficile en effet de trouver le temps de faire de la veille métier en plus de toutes ses tâches quotidiennes. D’autant que dans un contexte d’explosion numérique, la veille métier englobe de plus en plus de thématiques et génère de plus en plus d’informations à traiter et assimiler.

Et cela ne s’arrête pas là, car on ne fait pas de la veille pour la simple beauté de la veille : l’étape suivante consiste à capitaliser sur ces informations pour les transformer en connaissances, se créer un système de gestion de connaissances personnelles et utiliser tout cela de manière concrète.

On entre alors dans le champ du PKM (Personal Knowledge Management), une discipline qui existe depuis les années 90, mais qui bénéficie aujourd’hui de beaucoup plus de visibilité et qui se démocratise notamment suite à la sortie de l’ouvrage de Tiago Forte « Construire un second cerveau : une méthode complète pour organiser votre vie numérique et libérer votre potentiel créatif », un best-seller paru en 2022 (2023 pour la version française) et vendu à plus de 100 000 exemplaires à travers le monde.

Dans cet article, nous vous expliquons comment les professionnels de l’information peuvent mettre en place ou améliorer leur système de gestion de connaissances personnelles en tirant parti des enseignements de l’ouvrage « Construire un second cerveau » de Tiago Forte.

Comment créer un système de gestion des connaissances personnelles simple, efficace, flexible et pas trop chronophage capable de s’intégrer dans ses activités quotidiennes ?

J’ai testé pour vous : créer un second cerveau numérique pour capitaliser efficacement sur sa veille métier

La veille métier veille/infodoc et la gestion des connaissances qui s’en suit fait partie de mes pratiques depuis de nombreuses années. Cela me permet notamment de rester à jour, m’aide à développer mes compétences métier et me sert aussi à trouver des idées de sujets pour Bases et Netsources, bénéficier d’une base de matière brute pour rédiger des articles, préparer des formations ou des conférences et plus largement nourrir ma réflexion.

Ce système de veille/PKM (Personal Knowledge Management) a évolué avec les années aussi bien au niveau des contenus que des outils et technologies utilisés. Et si depuis quelques années, j’avais un système qui répondait bien à mes besoins et attentes, j’ai pu constater au cours des derniers mois qu’il arrivait un peu à bout de souffle et qu’il était temps de le faire évoluer. En cause : certains outils qui se dégradent, un volume d’informations toujours plus important à prendre en compte sans pour autant avoir plus de temps à y consacrer et des briques intermédiaires de ma réflexion qui continuent à se perdre ou qui prennent trop de temps à être retrouvées.

J’ai donc décidé de tester les méthodes préconisées par Tiago Forte dans son ouvrage « Construire un second cerveau » et par Sönke Ahrens dans « Comment prendre des notes intelligentes ». Retour sur mon expérience et sur les bénéfices apportés.

Comment extraire gratuitement les commentaires des réseaux sociaux ?

Sur le Web, les commentaires publiés sous des articles, billet de blogs et sous les posts des réseaux sociaux peuvent parfois receler de véritables pépites mais ce sont des contenus difficiles à intégrer dans ses veilles et recherche d’information. En effet, on peut ponctuellement avoir besoin de plonger dans les commentaires sur les réseaux sociaux, par exemple pour une étude d’image, pour obtenir des informations complémentaires à l’article lui-même, pour y trouver des réponses, pour les analyser en vue d’une étude ou les sauvegarder en vue d’un usage futur.

Mais comment extraire les commentaires associés à un tweet sur Twitter, ou à un post sur Facebook, Instagram, LinkedIn, YouTube et les autres surtout quand ils sont nombreux et qu’on on ne dispose pas de budget ni d’un besoin suffisant pour acquérir une grosse plateforme payante ? Nous avons choisi ici l’angle des outils gratuits ou peu onéreux car l’extraction de commentaires ne représente souvent qu’un besoin ponctuel pour les professionnels de l’information et ne justifie donc pas l’acquisition d’une plateforme très onéreuse.

C’est ce que nous avons exploré dans cet article en testant différentes méthodes et outils et en vous proposant la meilleure issue de nos tests.

Lire aussi :

Comment surveiller Twitter après la fermeture en cascade des outils dédiés ? (Bases N° 413 - avril 2023)

Réussir à utiliser LinkedIn pour la veille et la recherche d’information (Netsources N° 158 - mai/juin 2022)

Veille Instagram : quoi, comment, pour quoi faire ? (Netsources N° 158 - mai/juin 2022)

Comment intégrer YouTube dans votre dispositif de veille (Netsources N° 157 - mars/avril 2022)

Facebook : toutes les clefs pour ouvrir ce coffre bien fermé à la veille ou la recherche (Netsources N° 158 - mai/juin 2022)

L’art du prompt pour le professionnel de l’information

L’un des thèmes récurrents autour de ChatGPT et autres IA génératives concerne la question des prompts - c’est-à-dire les requêtes utilisées pour communiquer avec l’IA - avec l’idée que la qualité des réponses et contenus produits par ces outils dépendraient de la qualité des prompts.

A priori rien d’insurmontable pour les professionnels de l’information qui ont toujours appris à interroger et manipuler les différentes générations d’outils pertinents pour l’exercice de leur métier.

Toutefois, cette fois-ci, cette compétence vaudrait de l’or à en croire la société Anthropic (créateur de Claude, l’un des concurrents de ChatGPT) qui propose un poste de « Prompt Engineer and Librarian » avec un salaire débutant à 300 000$ (Source Time et Jobs Lever), bien loin des standards habituels.

Le professionnel de l’information va-t-il enfin être reconnu à sa juste valeur ? Rien n’est moins sûr… Mais toujours est-il qu’aujourd’hui, on ne peut pas faire l’impasse sur l’IA dans l’exercice de son métier.

La compréhension et la maîtrise des prompts est donc un axe-clé qu’il va falloir comprendre et maîtriser.

C’est ce que nous aborderons dans cet article en démêlant le vrai du faux pour faire la différence entre ce qui est vraiment utile pour communiquer avec l’IA et ce qui relève d’arguments purement commerciaux et marketing puis en proposant des éléments de méthodes pour tirer parti au mieux des outils à base d’IA à partir de nos propres tests et de discussions avec plusieurs professionnels qui utilisent l’IA dans leurs pratiques.

Lire aussi :

Comment l’IA enrichit les livrables de veille multilingue ? (Netsources N° 163 - mars/avril 2023)

Revue des moteurs de recherche à l’heure de ChatGPT (Bases N° 413 - avril 2023)

Quels outils utiliser pour bénéficier de ChatGPT ? (Bases N° 410 - jan 2023)

Détecter un contenu écrit par ChatGPT : IA face à l’IA (Gratuit - 02/2023)

Notre sélection d’annuaires d'outils IA (Article en accès libre - Bases N° 414 - mai 2023)

Comment identifier les dispositifs d’aides publiques et privées

La recherche de financements est souvent au cœur des préoccupations des entreprises, des instituts de recherche et des universités, ainsi que des associations.

Réussir à identifier des financements demande une rigueur certaine car il existe des milliers de dispositifs d’aide à l’entreprise en France, et la même information est relayée par beaucoup de moteurs de recherche et quelques listes de sources à ne pas omettre.

Nous vous proposons ici une démarche méthodes/outils complète pour agir de façon structurée et la plus exhaustive possible dans la recherche de financements.

Poser les bonnes questions à son client

Le professionnel de l’information n’est pas forcément un expert en financements, et, un brief client sur les questions financières demande un haut niveau de confiance. Car les types d’aides sont divers et les filtres des moteurs de recherche touchent le cœur de la stratégie financière d’un client puisqu’ils concernent les sources et la nature des financements (emprunts bancaires, partage de capital, subventions par quel type d’organisme, avec ou sans apport, etc.).

En cas de création ou de reprise d’entreprise, on pourra s’aider de ce questionnaire de Bpifrance, qui commence par distinguer les financements pour une étude de faisabilité/un prototype, le projet dans son ensemble, un besoin de trésorerie, des investissements.

Veille multilingue : comment trouver ses mots ?

Toute veille débute par une phase d’identification des mots-clés qui serviront aux futures requêtes et alertes. Cette étape cruciale se complexifie quand la veille est internationale et nécessite de prendre en compte la question du multilinguisme.

Mais a-t-on encore besoin de maîtriser plusieurs langues étrangères pour identifier les mots-clés d’une veille multilingue ? Les dernières avancées de l’IA et l’arrivée de ChatGPT peuvent-elles nous être utiles lors de cette étape ? Et faut-il à tout prix se lancer directement à la recherche de mots-clés en langues locales que l’on ne maîtrise pas ?

On pourrait penser qu’il faut impérativement commencer par identifier des mots-clés en langue locale alors qu’il est souvent plus judicieux de commencer avec les langues que l’on maîtrise le mieux et pour lesquelles on a des repères et connaissances solides.

Veille internationale : comment trouver des sources en langue étrangère ?

Identifier des sources dans une langue étrangère nécessite de sortir de sa zone de confort. Il faut non seulement se plonger dans un paysage médiatique et culturel différent, mais aussi minimiser son risque d’erreur d’interprétation.

Pour illustrer la méthodologie à suivre, nous prendrons comme exemple la réalisation d’un sourcing pour la mise en place d’une veille sur le marché de la restauration en Malaisie.

Lire aussi :

Sourcing, de la théorie à l’épreuve de la pratique (Netsources N° 146 - mai/juin)

Sourcing : les outils professionnels suffisent-ils pour s’aventurer en terrain inconnu (Netsources N° 146 - mai/juin)

Sourcing : peut-on faire l’impasse sur les recherches en langue locale ? (Netsources N° 146 - mai/juin)

Fiche Pratique : Les sources-clés pour la veille à l’international

Comment enrichir son sourcing grâce à Google Sheets, Airtable & les autres ?

Dans le cadre d’une recherche d’informations, le premier réflexe pour identifier des sources est généralement de cibler des médias, des experts, voire des annuaires. Mais il existe une autre ressource utile pour fournir de l’information et à laquelle on pense moins : les listes de sources disponibles sur des tableurs en ligne comme Google Sheets ou Airtable et qui se multiplient.

La volonté de partager des listes de sources sur le Web a toujours existé, surtout avec l’avènement du Web 2.0. Mais le format ainsi que les outils de partage et d’hébergement de ces listes ont évolué. Il y a eu le temps des annuaires (qui sont finalement des sortes de listes), le temps des blogrolls sur les blogs, des outils de bookmarking, des FollowFriday et des listes sur Twitter, etc.

Aujourd’hui, outre Google Sheets, de nouveaux outils de création de bases de données ‘no-code’ et de tableurs en ligne ont vu le jour, dont le plus connu est Airtable. Ces tableurs sont souvent partagés publiquement par des experts, consultants ou autres acteurs d’un secteur particulier, qui disposent en échange de la gratuité du service.

Ces listes plus ou moins exhaustives peuvent se révéler précieuses, car elles constituent un pré-tri de l’information opéré par une personne suffisamment intéressée et experte pour entreprendre ce travail de recherche et de structuration. Elles permettent donc d’aller au-delà pour dénicher des sources utiles, voire des pépites, ou même des idées de structuration de l’information.

Comment retrouver la trace d’une personne décédée au XIXe siècle ?

C’est une question qui revient régulièrement : retrouver la trace d’une personne décédée aux siècles précédents dans le but d’identifier dans quel cimetière elle a été enterrée, retrouver des informations pour comprendre les raisons de son décès, garder une trace d’un fait divers pour l’inclure et illustrer un dossier documentaire ou une biographie, etc.

Toutes ces demandes ont un point commun : elles nécessitent d’entrer dans le monde des archives et dans l’idéal même le monde des archives en ligne, ce qui évite de se déplacer.

On sort alors complètement des sources que l’on peut avoir l’habitude d’interroger sur le Web et ce type de requête demande une démarche spécifique.

Lire aussi :

Tous les outils pour rechercher dans les archives du Web (02/2022)

La recherche d’information appliquée aux personnes (04/2019)

L’analyse automatique d’un corpus de presse pour mieux cibler sa veille

La datavisualisation a un rôle à jouer à toutes les étapes de la veille comme nous avons pu le voir dans le précédent numéro de NETSOURCES. Cela commence dès les premières étapes de la veille avec la définition précise d’un sujet ainsi que le choix des mots-clés et du champ lexical à utiliser pour créer de futures alertes.

Dans cet article résolument pratique, nous avons voulu montrer comment la représentation de données pouvait apporter une aide précieuse dès cette première étape de formalisation du besoin et surtout comment s’y prendre concrètement, avec quelles méthodes et quels outils.

- Nous sommes donc partis d’un cas concret : la mise en place d’une veille sur un sujet dont nous avons tout à découvrir : ChatGPT.

Pour nous aider à déterminer les angles de la veille, les thèmes à surveiller et les termes à mettre sous surveillance, nous avons choisi d’analyser un gros volume d’articles de presse sur le sujet, car même si ChatGPT est apparu récemment dans les médias, le volume d’articles consacré à cette IA est considérable et donc peu assimilable humainement.

Les outils de Business Intelligence pour créer des analyses visuelles dans un livrable de veille

La dataviz a un rôle important à jouer dans la réalisation des livrables en permettant notamment de représenter visuellement des informations et des analyses qui auraient pu avoir beaucoup moins d’impact si elles avaient été uniquement restituées sous forme de texte.

Mais utiliser la dataviz dans ses livrables, ce n’est pas appuyer sur un bouton pour récupérer en un clic toute une série de représentations graphiques adaptées à ses problématiques. Ce serait trop beau. C’est en réalité beaucoup plus complexe et fastidieux et nous en avons fait l’expérience à partir d’un exemple concret.

L’essentiel de la dataviz

Cette nouvelle rubrique « FICHE SYNTHETIQUE » se propose d’aider à comprendre en un clin d’œil les informations clés de chaque numéro de NETSOURCES. La datavisualisation faisant l’objet d’un numéro double, vous trouverez ici un rappel du précédent numéro. Cette rubrique sera également déclinée en version pédagogique « pas à pas » et commentée dans nos fiches pédagogiques « Les essentiels de la veille». Bonne lecture !

Mode d’emploi pour mettre en place une veille sur Mastodon

À l’heure où le réseau social Mastodon profite des mésaventures de Twitter au point d’être parfois présenté comme une véritable alternative décentralisée, il est temps de se demander : comment faire de la veille sur Mastodon ?

Et le moins qu’on puisse dire, c’est que ce n’est pas intuitif. Malgré des similarités visuelles avec Twitter, Mastodon n’a pas du tout le même mode de fonctionnement ni les mêmes fonctionnalités.

Nous sommes donc partis d’un exemple concret : réussir à mettre en place sur Mastodon une veille métier autour de la veille, sujet ô combien important pour les veilleurs pour rester à jour dans leur métier et dans leurs pratiques.

Car, si Mastodon souhaite avoir une chance d’exister face à Twitter, le veilleur doit pouvoir basculer ses précédentes activités de Twitter vers Mastodon. Mais Twitter reste difficile à détrôner. Il conserve une place très importante pour le professionnel de l’information notamment pour sa propre veille métier grâce aux nombreux experts et fonctionnalités avancées qui s’y trouvent.

Alors comment et surtout peut-on reproduire le même schéma sur Mastodon ? Pour y parvenir, il faut effectivement qu’il y ait suffisamment d’experts sur Mastodon qui publient sur la thématique ciblée et que Mastodon nous fournisse des fonctionnalités suffisamment abouties pour pouvoir rechercher des contenus, identifier des utilisateurs pertinents et suivre leurs publications. C’est ce que nous allons vérifier dans cet article.

Les Tags de Bases

- IA

- brevets

- cartographie

- SEO

- open access

- livrables de veille

- humain

- médias sociaux

- moteurs académiques

- revues académiques

- sourcing veille

- flux RSS

- professionnel de l'information

- dirigeant

- open data

- recherche vocale

- information business

- agrégateurs de presse

- à lire

- conférences salons

- information scientifique et technique

- outils de recherche

- outils de veille

- tendances

- multimédia

- actualités

- méthodologie

- serveur de bases de données

- curation

- due diligence

- recherche visuelle

- outils de traduction

- fake news

- fact checking

- publicité

- géolocalisation

- marques

- appels d'offres

- sommaire

- formation Veille Infodoc

- retour d'expérience

- OSINT

- agenda

- propriété intellectuelle

- presse en ligne

- recherche Web

- évaluation outils

- biomédical

- Questel

- Dialog

- références bibliographiques

- thèses

- résumé automatique

- Bing

- open citation

- Scopus

- veille collaborative

- outsourcing

- veille audiovisuelle

- veille innovation

- infobésité

- études de marché

- données statistiques

- dataviz

- information financière

- Corée du Sud

- Pressedd

- LexisNexis

- Newsdesk

- sourcing pays

- chimie

- e-réputation

- recherche publique

- droit d'auteur

- littérature grise

- archives ouvertes

- veille medias

- dark web

- veille commerciale

- trésor du web

- réseaux sociaux

- veille à l'International

- ist

- ChatGPT

- veille métier

- intelligence économique

- veille concurrentielle

- Bluesky

- podcast

- dark social

- shadow social

- science ouverte

- open source

- veille technologique

- knowledge management

- littérature scientifique

- web of science

- derwent

- abstracts

- protocole

- Intelligence artificielle

- OpenAI

- Commerce conversationnel

- GEO

- veille automatisée

- agents conversationnels

- recherche biomédicale

- veille informationnelle

- Afrique

- copyright