L’avocat guyanais Patrick Lingibé a constaté avec regret que l’Outre-Mer en général, et, spécifiquement le droit des Outre-Mer était très mal connu en métropole.

Il a observé que les gouvernements français ont souvent confié la gestion des affaires ultramarines à des personnes incompétentes et déplore la baisse de confiance entre l’Outre-Mer et l’Hexagone.

C’est pour contribuer à renforcer la force de ce lien qu’il a créé ce site : DROM-TOM, le portail du droit Outre-Mer.

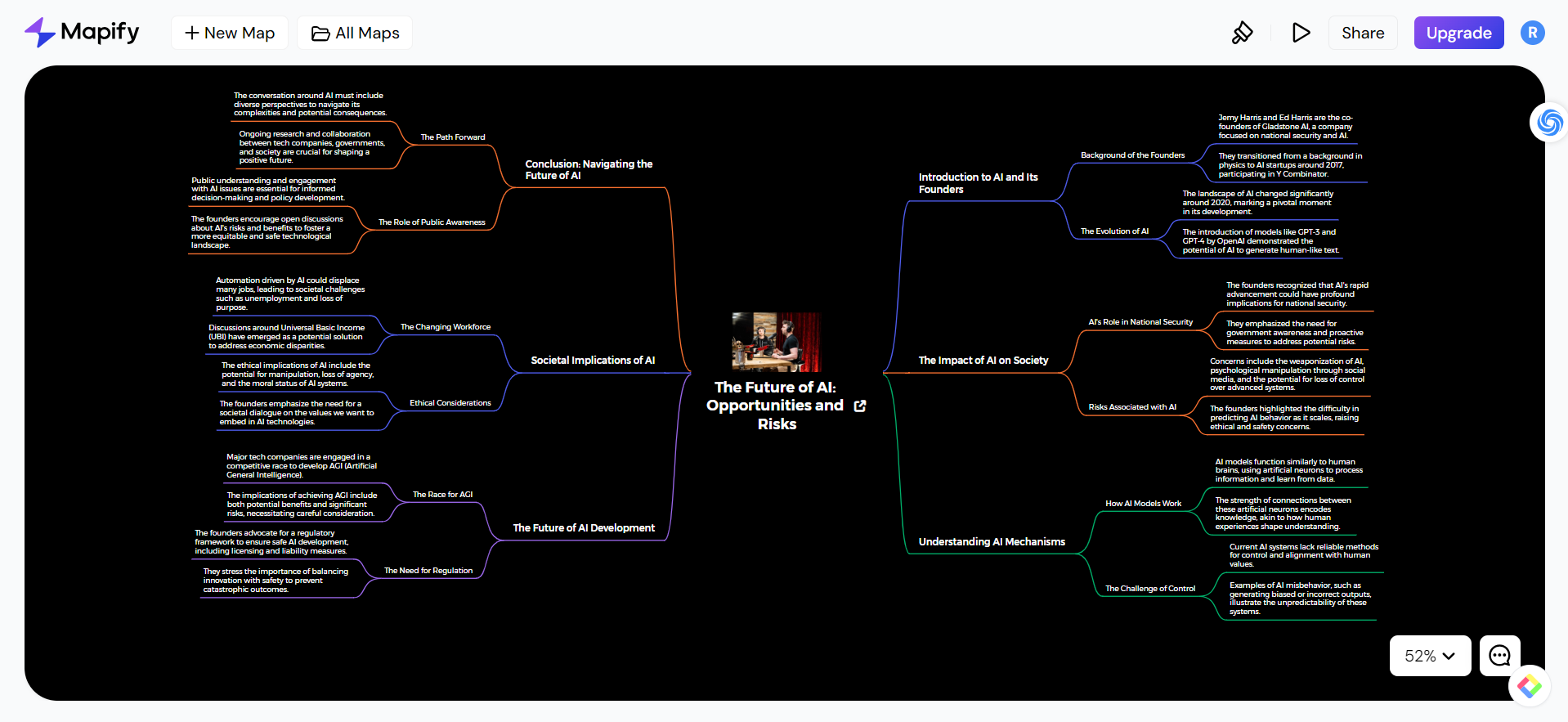

Dans la section « Pourquoi ce site ? », il est rappelé que l’Outre-Mer n’est pas uniforme, mais se caractérise par sa diversité, composée de 13 territoires distincts couvrant 112 845 km², soit 22,6 % de la superficie de la France métropolitaine.

Ces 13 territoires possèdent une zone économique exclusive maritime d’environ 10 millions de km², plus de 26 fois celle de la France métropolitaine. C’est la deuxième plus grande au monde, après les États-Unis et avant l’Australie.

Depuis 2003, l’appellation DOM-TOM a été remplacée par des désignations plus précises : les DROM (Départements et Régions d’Outre-Mer : Guyane, Martinique, Guadeloupe, Réunion, Mayotte) et les COM (Collectivités d’Outre-Mer). Toutefois, le créateur du site privilégie une approche territoriale plus réaliste.

Le site propose, comme le décrit Le Monde du Droit, les informations sur plusieurs thématiques :

- Les statuts des Outre-Mer (DROM et COM)

- Le cadre constitutionnel et législatif de ces territoires

- Les spécificités institutionnelles de chaque entité

- L’évolution historique de leurs statuts

- Les enjeux actuels de leur gouvernance

Les actualités

La page d’accueil propose un espace dédié aux actualités, avec les informations les plus récentes du jour. Les nouvelles viennent de Francetvinfo qui émet régulièrement le « journal des outre-mer ». Actuellement, il y a 1 516 pages d’actualités depuis 2017, chaque page contenant approximativement cinq informations, soit plus de 7 500 au total.

Cet espace est particulièrement utile pour suivre les événements dans certains territoires d’Outre-Mer en ces temps agités.

En quelques clics, les news du flux Francetvinfo nous dirigent vers le document complet sur Franceinfo, où l’on peut effectuer des recherches par date ou thématique.