-

Vous êtes ici :

- Accueil

- Publications

- Netsources

Sélectionner le numéro de "Netsources" à afficher

Nous avons testé les contenus des différents outils de recherche d’information scientifique en accès libre

Notre habitude est de construire des stratégies complexes, mêlant synonymes, mots écrits de différentes façons (crosslink ou « cross link » par exemple), avec des opérateurs booléens, de proximité, des possibilités d’exclure des thématiques et, enfin, de multiples possibilités de combiner des étapes. Autant le dire tout de suite, ces stratégies ne sont pas transposables en l’état dans ces nouveaux outils.

Pour réaliser nos tests, nous avons donc dû utiliser des stratégies relativement simples qui puissent fonctionner sur tous les outils. Nous nous sommes limités aux références d’articles ou de conférences, incluant les preprints qui sont de plus en plus pris en compte. En revanche nous n’avons pas, dans la mesure du possible, pris en compte les chapitres d’ouvrages et les thèses. Les recherches se font dans le titre, ce qui n’est pas toujours simple, certains systèmes n’offrant pas cette option, obligeant à faire des comptages manuels. Nous avons envisagé de tester une recherche par affiliation mais cette fonctionnalité n'est pas disponible dans tous les moteurs.

Cette comparaison entre les serveurs et les outils gratuits ne pouvant se faire que sur des stratégies simples, on laisse de côté la puissance de recherche et le confort d’utilisation pour ne comparer que le nombre de réponses. Par ailleurs, il est évident que ces tests n’ont aucune valeur statistique et que l’on ne peut rien généraliser à partir de leurs résultats.

- Notre première recherche test porte sur le terme «

interoperable» dans le titre de documents publiés en 2024. Nous avons choisi ce terme car c’est une requête très simple sur des outils aux fonctionnalités parfois peu avancées. De plus ce terme est souvent utilisé dans de nombreux domaines scientifiques. - La deuxième recherche porte sur l’expression «

cross language information retrieval» dans le titre pour des documents publiés en 2023 et 2024. Ici nous avons une requête de test sur une expression.

Venons-en maintenant à l’analyse des résultats dans les différents outils.

Matilda

C’est un des moteurs dont on parle beaucoup actuellement et qui de plus répond bien, cependant, dans notre premier exemple quelques réponses proviennent de IEEE Xplore (voir plus loin) où elles étaient publiées déjà l’année précédente. On note une référence originale de l’université de Ljubljana. On suppose que la recherche se fait, par défaut, sur l’ensemble de la référence et le texte de l’article. On peut classer les réponses par pertinence ou par date.

Déjà abonné ? Connectez-vous...

Connexion

Maîtriser l'Open Data et l'IA pour transformer et exploiter les données différemment

En France, pays champion européen de l’open data, on parle souvent des startups qui parviennent à exploiter des données accessibles en accès gratuit, pour en faire des services, avec parfois une option payante, à l’instar de Pappers ou Doctrine.

Depuis la démocratisation de l’IA amorcée il y a plus d’un an avec la mise à disposition au public de ChatGPT, suivie depuis par d’autres IA génératives et services afférents, comment le traitement des données ouvertes a-t-il évolué et surtout, est-il davantage accessible à un utilisateur sans formation technique particulière en amont ? Exploration, étape par étape, du traitement des données, de l’extraction à la publication.

Extraction facilitée

Première étape : la collecte des données. Celle-ci peut se faire de deux façons : en téléchargeant un dataset ou en procédant à l’extraction des données sur un document. C’est dans ce second cas que les outils IA interviennent. S’offrent alors deux possibilités d’extraction de données :

- Avec un outil IA où l’on importe un fichier de données.

- Avec un tableur habituel, auquel on ajoute un module IA.

Avec un outil IA

Les outils IA qui permettent d’importer gratuitement des documents à traiter ne prennent pas en charge les formats de bases de données, mais uniquement les formats textes et PDF. Dans ce cas, extraire les données d’un document pour les récupérer sous forme texte ou de tableau est un jeu d’enfant.

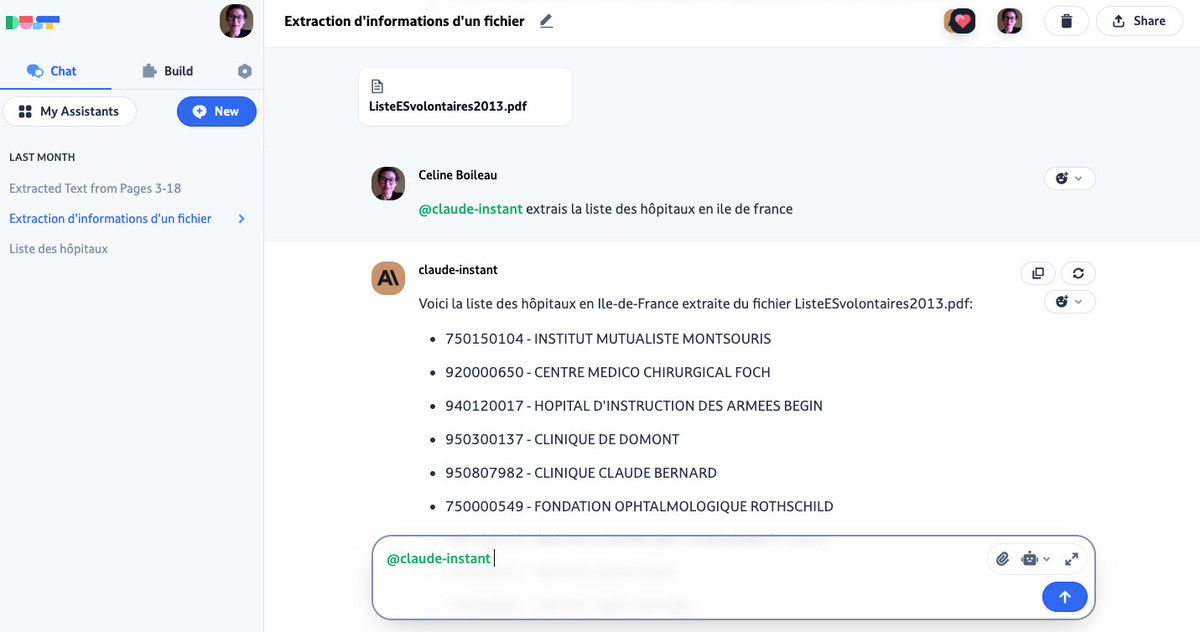

Prenons par exemple ce document qui dresse une liste des hôpitaux en France en 2013, trouvé par une requête Google « liste hôpitaux en France PDF ».

- Pour en extraire les hôpitaux d’une région, on a d’abord utilisé DUST, un outil IA français d’analyse de données. Un autre outil existe avec des fonctionnalités similaires, Retune. Le procédé est simplissime : on colle le lien ou on importe le document (formats TXT, PDF et MD (Markdown), de taille inférieure à 10 Mo), on choisit le modèle de langage (GPT 3.5 ou Claude) et on rédige son invite. L’extraction de données ne peut se faire qu’avec Claude et non avec GPT 3.5. Dans ce cas, un simple « Extrais la liste des hôpitaux en Île-de-France » suffit à récupérer une liste sous forme de texte. En revanche, les tentatives pour fournir les résultats sous forme de fichier à télécharger n’ont pas abouti.

Figure 1 : L’extraction de données ave DUST. Sur simple demande.

- Un autre test avec un PDF de 22 pages, agrémenté de nombreux graphiques, a aussi permis d’extraire le texte, pour ensuite le résumer. Et comme l’invite était en français, Claude s’est exécutée en français, faisant l’économie d’un prompt (ou invite) de traduction.

- Un autre outil, plus connu des veilleurs, est le moteur de recherche Perplexity. Ici aussi, il est possible d’importer un PDF ou un TXT pour en extraire les données sous forme de texte. Il faudra en revanche les copier-coller. On remporte le même succès avec Copilot (ex-Bing Chat).

- Enfin, on pensera aux outils d’interrogation de documents, comme ChatPDF, qui permet l’extraction des données à partir d’un PDF de plus de 100 pages.

La différence entre ces outils réside non seulement dans la qualité de l’extraction, mais surtout dans les formats de documents importables et exportables.

Déjà abonné ? Connectez-vous...

Connexion

IA open source : une opportunité pour le veilleur ?

L’année 2023 a été marquée par la démocratisation des IA génératives. Cette technologie de pointe, qui a émergé sur le marché en 2020, était alors réservée à quelques experts qui payaient une API. Amorcée par la mise sur le marché de l’interface gratuite ChatGPT d’OpenAI, dont la plupart des produits sont devenus payants dans les mois qui ont suivi, cette démocratisation pourrait néanmoins perdurer grâce au développement de modèles de langage sous licence ouverte (ou « open source »).

Cette licence permet en effet d’exploiter un modèle de langage pré-entraîné à moindres frais (moins de 500 dollars dans la plupart des cas et avec des ressources de calcul modestes), ouvrant ainsi l’accès à un large éventail de chercheurs, de développeurs et d’organisations.

Le paysage du veilleur

Des outils difficilement identifiables

Il existe néanmoins quelques freins pour que le veilleur puisse en profiter.

- Premièrement, ces outils restent difficilement identifiables et utilisables malgré les effets d'annonce. La première raison qui rend difficilement identifiables les outils d’IA open source réside dans la définition même d’une « IA open source », laquelle est trop souvent confondue avec la gratuité. Toutefois, pour l’Open Source Initiative (OSI), l’organisation qui défend « une économie du logiciel dépendant de la vente de prestations et non de celle des licences d’utilisation » l’IA open source doit permettre :

- L’étude du fonctionnement du système et l’inspection de ses composants ;

- L’utilisation de son système à n’importe quelle fin, sans avoir à demander la permission ;

- La modification du système pour changer ses recommandations, prédictions ou décisions afin de l’adapter à ses besoins ;

- Le partage du système avec ou sans modifications, à quelque fin que ce soit.

- La deuxième raison qui rend ces outils difficilement identifiables est la difficulté à identifier ce qui est open source dans une IA.

Disons-le franchement, la confusion règne entre les noms des produits/outils (par exemple, un chatbot), des modèles de langage et des algorithmes. Ils ont parfois le même nom alors qu’il s’agit de trois entités distinctes. Le veilleur, en tant qu’utilisateur final, manipule des outils. Ces derniers reposent sur un modèle de langage (LLM), qui lui-même repose sur un algorithme (et un mode d’apprentissage).

Par exemple, chatGPT est un outil (un chatbot) qui fonctionne avec le LLM propriétaire GPT 3.5, qui désigne aussi son algorithme. Gemini est à la fois un chatbot de Google accessible gratuitement, mais aussi le nom de son modèle de langage (LLM) qui n’est pas en open source non plus, ainsi que de son algorithme !

Enfin, certains outils, comme le moteur de recherche Perplexity, reposent sur un modèle mixte. Il a développé son propre modèle mais il utilise aussi Copilot (outil propriétaire de Microsoft) et LLaMA (modèle ouvert de Meta).

Des modèles peu nombreux … mais de qualité

Par ailleurs, malgré une expansion marquée récemment par la success story de Mistral, la startup « française » créée il y a quelques mois et déjà valorisée à deux milliards de dollars pour son modèle de langage open source, cette licence reste minoritaire dans les outils IA du veilleur.

Sur le portail d’outils IA Futurepedia qui recense plus de 5 000 outils (voir notre article en accès libre, Focus IA : notre sélection d’annuaires d’outils IA, Bases N°414 - mai 2023) et dispose d’un filtre Open source, on note cette proportion :

- 20 générateurs de prompts sur 132 sont en open source

- 15 générateurs de texte sur 294

- 0 outil de réécriture sur 28

- 7 outils de copywriting/aide à la rédaction sur 209

- 2 outils marketing sur 81

Mais dans la dizaine d’outils consultés, rares sont ceux qui précisent leur modèle de langage !

Cette faible proportion d’outils s’explique par le fait que les modèles de langage accessibles en open source s’adressent davantage aux développeurs qu’aux utilisateurs finaux.

Une autre explication réside sans doute dans le fait que les LLM open source manquent encore de fine tuning, ou ajustement. Or, c’est cette phase finale qui assure un niveau de précision suffisant, pour être exploité par un utilisateur final.

Déjà abonné ? Connectez-vous...

Connexion

Les clés du paysage médiatique français

Les chiffres clés

• Nombre de titres de presse écrite (2021, Ministère de la Culture) : 3872

• Nombre de radios (2022, Arcom) : + 1000

• Nombre de chaînes de télévision (2022, Arcom) : 30 chaînes nationales

• Classement de médias numériques (2021, Mind Media, par nombre d’abonnés) : Le Monde, L’Équipe, Le Figaro, Ouest-France, Les Échos, Libération, Le Parisien.

Les principaux groupes de presse

Vivendi (V. Bolloré) : Groupe Canal + (Canal+, Canal+ Cinema, Planète+, Canal+ Sport), CNews, C8, CStar), Prisma Media (Géo, Femme actuelle, Gala), Lagardère News (JDD, Europe 1, Paris Match, RFM, Europe 2, Elle International), etc.

NJJ Holding (X. Niel) :

- NJJ Presse : La Provence, Causeur, Les Jours, L’Informé, France Antilles, Paris Turf.

- NJJ Presse/Fonds pour l’indépendance de la presse : Groupe Le Monde (Le Monde, Le Monde Diplomatique, L’Obs, Télérama, Courrier international La Vie, etc.), Groupe Nice Matin (Nice Matin, Var Matin, Monaco Matin).

- Mediawan : AB1, RTL9, Ation, 14 chaînes de télévision, 50 labels de production dont Studio Lagardère.

LVMH (B. Arnault) : Les Échos, Le Parisien/Aujourd’hui en France, Investir, Historia, Challenges, Mieux Vivre Votre Argent, La Lettre de l’Expansion, Sciences & Avenir, Mezzo, Connaissance des Arts, etc.

Czech Media Invest (Kretinsky) : Elle, Marianne, Version Femina, Télé 7 jours, France Dimanche, Ici Paris, Public, Art & Décoration, Libération, Usbek & Rica, Franc-tireur.

Reworld Media : Auto Moto, Auto Plus, L’Auto Journal, Science & Vie, Science & Vie Junior, Marie France, Maison et Travaux, Télé Poche, Télé Star, Biba, Be, Diapason, Psychologies, Pleine Vie, Le Chasseur français, Vital, etc.

Identifier le paysage local

- Les éditions régionales des médias nationaux

- Les médias régionaux/locaux mainstream

- Les médias indépendants locaux et hyperlocaux

- Les médias des collectivités

Méthodologie

- Identifier les collectivités du périmètre de surveillance ;

- Récupérer les URLs des sites Web (via les annuaires de presse et les sites institutionnels des collectivités, voir ci-dessous) ;

- Identifier les modalités de mise en veille ;

- Pour les sources sous forme de PDFs, les stocker dans les dossiers de son ordinateur, les outils de bookmarking et de prise de note, ou de stockage comme Zotero, etc. pour les interroger ponctuellement.

Les ressources

Déjà abonné ? Connectez-vous...

Connexion

Comprendre le paysage médiatique actuel pour maîtriser sa veille

La connaissance des médias est une compétence essentielle du sourcing et de l’analyse dans la veille informationnelle. Pourtant, les professionnels de la veille et des médias ne se côtoient que trop rarement. Or, connaître l’univers - et la diversité - médiatique est justement ce qui permet de constituer un corpus complet, c’est-à-dire qui prend en compte l’ensemble des opinions autour d’une question. Visite guidée, à l’aube d’une prochaine disruption médiatique.

Le paysage médiatique français est constitué d’un grand nombre de titres traditionnels : plus de 5000 titres de presse écrite, radios et chaînes de télévision en 2021, selon les chiffres du ministère de la Culture et de l’Arcom.

• La hiérarchie de l’information de chacun est déterminée par une loi qui s’applique à tous : la loi de proximité (ou loi du mort/kilomètre) selon laquelle l’information considérée comme la plus importante, et qui sera donc mise « à la Une », est celle qui se rapproche le plus de son public. Cette proximité peut être géographique (presse locale ou nationale), sociale (presse en fonction de l’âge, par exemple), affective/émotionnelle ou encore professionnelle.

• Autre spécificité du paysage français, la place prépondérante de l’Agence France Presse (AFP). Celle-ci diffuse ses dépêches aux médias abonnés, c’est-à-dire à l’ensemble des médias mainstream. Ce qui explique que ces derniers commentent et décryptent souvent les mêmes faits, mais en fonction de leur propre ligne éditoriale. Les médias indépendants, eux, n’ont généralement pas le budget pour acheter un tel abonnement. Plus proches du « terrain », ils n’en ont généralement pas l’utilité non plus.

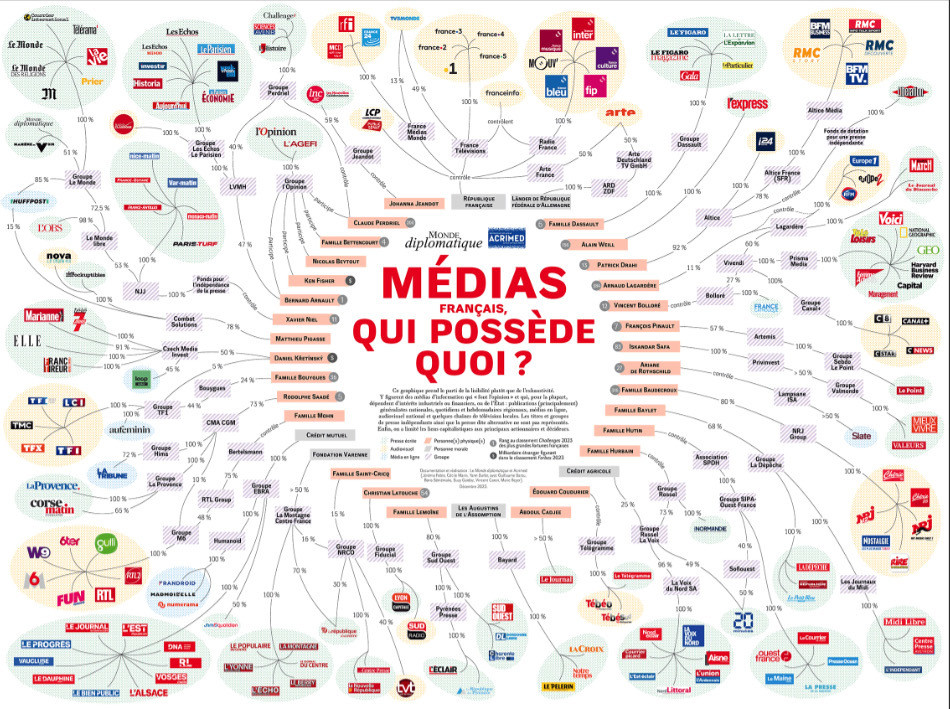

Une diversité éditoriale en demi-teinte

Pourtant, le grand nombre de médias ne reflète pas complètement leur diversité : il est régulièrement reproché aux plus importants diffuseurs, ceux qui « font l’opinion », d’appartenir à une trentaine de milliardaires (cf. Figure 1). Et cette structuration du marché français s’accentue par d’importants mouvements de concentration.

Seul le secteur de la radio est très peu concentré : parmi quelque 1000 radios, seuls quatre groupes privés disposent de plus d’une station (NRJ Group, M6, Lagardère et NextRadioTV). Mais les mouvements de concentration sont tels qu’une commission d’enquête a été mandatée par le Sénat en 2021, au regard de son impact potentiel sur le régime démocratique.

En face, les indépendants, souvent locaux, tentent de couvrir les déserts informationnels géographiques avec dynamisme.

Voir notre article « Comment profiter du renforcement de l'information locale pour son sourcing ? », NETSOURCES N° 167 - décembre 2023.

Figure 1 : Le Monde diplomatique/Acrimed, carte remise à jour tous les ans à l’adresse suivante

Déjà abonné ? Connectez-vous...

Connexion

Sourcing : l'info locale se renouvelle

Les médias locaux évoluent et cela impacte directement le sourcing et les pratiques de veille. Comment identifier et intégrer ces sources et verticales dans son sourcing ?

Il y a des veilles et des recherches d’information où la dimension locale est primordiale. L’information locale qu’il faut réussir à capter, c’est alors celle fournie par des journaux locaux, radios et TV locales, collectivités locales, mais aussi par des internautes désireux de partager des informations.

Ces différentes sources vont permettre d’obtenir des informations uniques et stratégiques notamment au niveau de la politique et de l’économie locale.

En France, quand on pense information locale, on pense avant tout à la PQR (presse quotidienne régionale) et à la PHR (presse hebdomadaire régionale) et par extension à un secteur touché de plein fouet par les difficultés rencontrées par la presse depuis des années.

On aurait vite fait d’extrapoler et de se dire que la veille locale en France risque d’être de plus en plus compliquée avec des sources et des informations locales moins nombreuses. Mais malgré ce sombre tableau, l’information locale n’a pas dit son dernier mot et se renforce même à différents niveaux et via différents canaux.

Dans cet article, nous explorons cette évolution et examinons ses répercussions sur la veille et la recherche d’informations.

Les défis actuels de la veille média au niveau local

La grande difficulté pour le professionnel de l’information, se situe lors du recensement des médias locaux pertinents, c’est-à-dire au moment du sourcing.

Il y a souvent une première couche de médias locaux faciles à identifier, les médias locaux mainstream qui vont revenir en boucle dans les recensements et outils de recherche et de veille. Il s’agit des journaux locaux ayant le plus de visibilité c’est-à-dire les grands titres de PQR comme Ouest France, Sud Ouest, Le Parisien, La Voix du Nord, Le Progrès, etc. Et une seconde couche à laquelle il est bien plus difficile d’accéder, avec des médias locaux plus « électrons libres » et moins visibles dans le paysage national qu’il va falloir réussir à pêcher.

Regardons les différents outils utilisés classiquement par les veilleurs et leurs capacités actuelles à détecter des médias locaux.

- La majorité des recensements de médias à l’échelle d’un pays, des annuaires de presse, etc. vont se focaliser sur les médias locaux mainstream. Peu de traces des autres médias locaux à l’exception de recensements spécifiquement dédiés aux médias locaux non mainstream.

- Du côté des outils de recherche, Google actualités reste une source importante pour la veille d’actualités notamment quand on a peu de budgets, mais il couvre mal la presse locale et hyperlocale. Il y a bien les principaux titres de PQR, mais la couverture devient vite moins bonne pour la PHR et très mauvaise pour les titres indépendants.

- Les agrégateurs de presse ont quant à eux une couverture locale variable : ceux qui ont une couverture mondiale comme Factiva ou Newsdesk proposent des médias locaux, mais on est là encore surtout sur des médias mainstream même s’il y a parfois quelques pépites. À l’inverse, il existe des agrégateurs de presse qui visent avant tout une couverture nationale et locale, à l’image de Tagaday en France, et ces agrégateurs vont avoir une excellente couverture des médias locaux.

- Du côté des outils de veille, les agrégateurs de flux RSS comme Feedly ou Inoreader référencent surtout les médias locaux mainstream dans leurs annuaires de sources incorporées. Pour les plateformes de veille, il faut regarder au cas par cas dans les corpus, mais la couverture locale française ou d’autres pays est très variable d’une plateforme à une autre. Impossible cependant d’être plus spécifique, car ces acteurs restent très discrets sur ce qui compose leurs corpus clé en main.

Le constat général est donc le suivant : les médias locaux mainstream ne sont généralement pas difficiles à identifier et sont souvent inclus dans les outils professionnels.

En revanche, l’identification des médias locaux indépendants ou de niche reste difficile à réaliser. Nous vous expliquons comment faire.

Déjà abonné ? Connectez-vous...

Connexion

Comment utiliser les journaux des collectivités locales ?

Les médias des collectivités locales sont des sources essentielles d’informations régionales au rôle bien singulier. Et comme l’intégration de ces ressources dans une veille reste un véritable défi, comment identifier, surveiller et intégrer ces médias à son système de veille.

Parmi les sources utiles pour trouver de l’information locale en France, les journaux des collectivités (communes, communautés de communes, départements ou régions) sont en bonne position. Ces médias ont une place bien à part dans le paysage des médias locaux. Ils ont la forme d’un journal ou d’un magazine, mais sont généralement la voix de l’équipe politique en place, à l’exception des quelques pages réservées à l’opposition.

Une fois que l’on a bien conscience du positionnement et des biais associés à ce type de publication, il n’en reste pas moins qu’on peut y trouver de l’information locale intéressante et parfois exclusive pour sa veille, notamment sous les angles de la politique et de l’économie locale, des acteurs locaux et de l’événementiel local.

Pourtant, réussir à les utiliser pour sa veille est loin d’être simple, car il n’existe à ce jour aucun agrégateur, outil centralisateur pour ce type de contenus et on se retrouve avec une multitude de magazines plus ou moins accessibles aux modalités et formats différents.

Dans cet article, nous verrons comment identifier ces médias, comment les mettre sous surveillance ou effectuer des recherches sur leurs contenus et comment leur trouver une place adéquate dans son système de veille.

Positionnement et évolution des journaux de collectivités

Avant de voir comment identifier et mettre en veille ces sources singulières, il convient de s’arrêter sur le positionnement et les dernières évolutions de ces sources. Le comprendre permettra ensuite de mieux les appréhender et mieux savoir où et comment les trouver.

En 2021, Le Courrier des Maires avait consacré un dossier complet aux médias et élus locaux et notamment à la place des magazines municipaux.

On y apprend que nombre de magazines municipaux ont été renforcés ces dernières années et bénéficient entre autres d’une pagination plus importante. Parfois, ce sont même d’anciens journalistes qui sont aux commandes de ces médias réinventés. Certains médias vont encore plus loin dans le développement du média municipal : lancement de hors-série, site dédié au magazine, lancement d’une app dédiée et même parfois lancement de podcast.

C’est par exemple le cas à Villeurbanne où « l’équipe du magazine municipal de Villeurbanne Viva ! a lancé un nouveau podcast “Sauce Samouraï”, qui revient sur une actualité de son territoire avec deux invités en 25 minutes. » (source : festival de l’info locale, mars 2023).

Le positionnement et la parole portée auraient aussi un peu évolué avec les années. Dans l’article, une des personnes interviewées, un consultant en communication, explique qu’« on ne fait plus seulement parler le maire ou ses amis, mais aussi les habitants. Les bulletins municipaux ou communautaires ne sont plus tant une profession de foi permanente qu’une contribution au débat public ». Mais l’article rappelle tout de même que ces médias ne peuvent pour autant pas être mis sur le même plan que la presse locale. Cela reste de la communication, financée par de l’argent public, mais aussi par des entreprises locales qui peuvent faire de la publicité dans le même magazine.

Pourquoi c’est important pour la veille ?

Le secteur des bulletins/magazines des collectivités est visiblement en forme et s’étend avec plus de produits et de contenus. Cela veut donc dire plus de contenus potentiellement pertinents pour la veille. Et comme il y a aussi une diversification des supports, il faudra aussi regarder s’il n’existe pas d'autres produits d'information potentiellement intéressants, comme des podcasts par exemple.

On gardera enfin en tête que même si la parole est peut-être plus donnée aux habitants que par le passé, ces magazines restent des exercices de communication qui n’ont pas vocation à montrer une pluralité de points de vue. On les consultera pour identifier des acteurs, entreprises ou startups locales, rechercher des événements locaux, détecter des projets et les éventuels problèmes liés à ces projets, faire une veille événementielle, mais on ne pourra pas les utiliser dans le but d’avoir une vision impartiale et objective de la politique locale.

Comment les identifier et les mettre en veille ?

La difficulté avec ces médias, c’est qu’il n’existe pas de moteur, agrégateur de presse ou base de données en indexant une majorité. Chaque commune a son propre format et son propre mode de diffusion et de stockage.

Ils peuvent être au format PDF sur le site Web, au format liseuse sur Calaméo, etc. Ils peuvent se trouver dans différentes pages des sites Web (page d’accueil, nos publications). Et il y a encore quelques années, il y avait des bulletins municipaux qui n’existaient qu’au format papier et étaient donc difficilement accessibles pour le veilleur.

Seulement un très petit nombre de médias municipaux sont référencés dans les outils classiques du professionnel de l’information. On peut ainsi tomber sur quelques résultats émanant de ces médias dans Google Actualités.

Si on veut inclure ces médias à sa veille et ses recherches, il va falloir les identifier spécifiquement, les mettre sous surveillance ou se créer ses propres outils de recherche dédiés.

La veille ciblée est la seule solution

D’emblée, on oubliera l’idée de mettre sous surveillance ou de créer un outil de recherche sur l’ensemble des médias des collectivités en France. Ce serait bien trop chronophage à réaliser, car il faut aller les récupérer un par un et surveiller la sortie de chaque nouveau numéro.

Déjà abonné ? Connectez-vous...

Connexion

Médias et IA : ce que cela change pour la veille

Après les moteurs de recherche et les médias sociaux, l’IA générative redistribue de nouveau les cartes pour les médias d’information. Avec des impacts considérables sur la production, la diffusion et la monétisation du contenu. Comment les médias s’adaptent-ils et comment cela affecte-t-il l’activité de veille ? Petit tour des initiatives en cours.

Dans ses recherches, au cours de ses analyses ou de la réalisation de ses livrables, le professionnel de la veille est de plus en plus exposé, de façon plus ou moins subtile, à l’information en provenance des IA génératives.

Au départ, les réponses créées par les chatbots d’IA générative comme ChatGPT, Bard et quelques autres, lui ont offert un autre mode d’accès à l’information : un accès direct aux réponses, sans cliquer sur les sources. Et cet usage devrait perdurer si l’on en croit la prochaine version de Google, SGE, qui valorise les réponses générées par IA au détriment des résultats de recherche présentés sous forme de liens.

Impacts sur la recherche

Des médias moins visibles dans les résultats des moteurs de recherche

Mais le contenu généré par IA commence aussi à concurrencer les médias sous une autre forme : des sites entièrement créés par IA s’invitent en effet dans les résultats des moteurs de recherche. Leur contenu, écrit pour correspondre aux règles actuelles de SEO, serait même mieux référencé que celui des médias. Récemment, le service américain de notation de l’actualité NewsGuard a identifié près de 600 sites Web (ils étaient 49 en mai dernier) qui fonctionnent avec peu ou pas d’intervention humaine. Et un site généré par l’IA produit jusqu’à 1200 articles par jour, contre 100 pour Le Monde ou 250 pour le New York Times ! Certains sont même financés par la publicité.

Les médias ont donc raison de craindre une baisse de leur propre trafic, qui provient à plus de 90 % de Google. Pour la veille, cela signifie davantage de difficultés à trouver certains contenus en provenance de médias pertinents, soudainement noyés dans des pseudos sites d’actualités générés par l’IA, mais difficiles à identifier, car ils reprennent les codes graphiques des sites d’actualités. Ce qui nécessite donc davantage de rigueur encore en phase de sourcing.

En revanche, pour le veilleur, les transcriptions de podcasts et de vidéos par les médias en format texte, consultable par les moteurs de recherche comme Google et Bing pourrait ainsi signifier de nouveaux résultats de recherche enrichis de ces transcriptions (enfin !).

La recherche au sein des sites médias

Mais d’autres initiatives en matière de recherche ont aussi lieu, à l’échelle individuelle de quelques médias : l’arrivée des chatbots au sein même des sites médias. En août dernier, un chatbot basé sur l’IA a été ajouté aux sites Macworld, PCWorld, Tech Advisor et TechHive. Ces derniers voulaient créer un chatbot « digne de confiance » (donc sans erreurs, sans citer de sources inexistantes ou inventer de fausses informations plausibles) pour répondre aux questions techniques en se fondant uniquement sur les articles des rédactions. Le chatbot, baptisé Smart Answers, apparaît dans presque toutes les pages des sites. Mais malgré des mois d’entraînement, le chatbot répond souvent, au mieux, qu’il ne sait pas/n’a pas assez d’information, y compris en cas des requêtes simples comme « quand est sorti le dernier produit Apple ? » ou « qui est le PDG de TikTok ? ». Au moins, n’invente-t-il pas juste pour avoir une réponse.

De son côté, Forbes dispose également, depuis peu, de son propre chatbot de recherche IA : Adelaide, dont il vient de sortir une version bêta (voir Figure 1). Les veilleurs peuvent donc poser des questions spécifiques (au-delà des mots-clés !) ou saisir des sujets généraux et obtenir des articles recommandés sur leur requête, ainsi qu’une réponse résumée à leur demande si elle a été couverte par la version américaine Forbes sur les douze derniers mois. Bien qu’Adélaide soit le premier outil d’IA générative construit par Forbes, le média avait développé d’autres outils dopés à l’IA depuis 2019.

Figure 1 : Résultat d’une question posée à Adelaide, le chatbot du média américain Forbes.

Déjà abonné ? Connectez-vous...

Connexion

Veille brevet : comment tirer un avantage concurrentiel de la propriété intellectuelle (article en accès libre)

Dans la plupart des entreprises, la veille brevet est souvent négligée. La veille brevet peut pourtant être une source d’informations précieuse pour l’intelligence concurrentielle. Elle permet de suivre l’évolution des technologies, d’identifier les concurrents, et d’exploiter toutes les opportunités de marché en développant une vraie stratégie. Entretien avec Philippe Borne, Délégué Régional de l’INPI pour la Région Grand Est (1), et également rédacteur occasionnel pour notre lettre BASES à titre d’expert.

François Libmann : La veille brevet a un potentiel qui nous semble sous-évalué dans le domaine de l’intelligence concurrentielle. Comment l’interprétez vous ?

Philippe Borne : Beaucoup d’entreprises ont une vision très juridique du brevet, considéré uniquement comme un outil de protection, et donc avec des stratégies brevet très traditionnelles. Et du fait de cette vision, on retrouve la même attitude en ce qui concerne la veille brevet. Cette vision très juridique du brevet en France a pour conséquence qu’il n’est pas tenu compte de son potentiel en tant que source d’informations pour l’intelligence concurrentielle. Cela ne vient, en effet, pas à l’esprit qu’on puisse faire de la veille technologique sur ce type d’information.

(1) Philippe Borne s’exprime ici à titre personnel et les opinions qu’il expose n’engagent que lui-même.

F. L. : Contrairement à la publication scientifique finalement.

P.B. : Oui, lorsque nous tombons sur une publication scientifique, c’est généralement beaucoup plus simple. Son rôle principal est de diffuser et partager l’information : on la lit, on la comprend, et on l’utilise. En revanche, le brevet a un objectif différent. Bien que la mise à disposition de l’information ait été l’intention première des créateurs du système des brevets en 1791, la fonction principale d’un brevet est de réserver un territoire technologique, c’est-à-dire d’en interdire l’accès à d’autres.

F. L. : La veille brevet est souvent perçue comme un outil d’accès difficile et coûteux, ce qui dissuade les entreprises de s’y investir.

P.B. : Oui, c’est vrai. La vision très juridique du brevet découle de la manière dont la propriété intellectuelle est enseignée en France. Le problème, c’est qu’il y a peu d’enseignement sur l’utilisation de cet outil pour servir une stratégie d’entreprise.

F. L. : Le problème de la veille brevet au service de la stratégie concerne plus les PME, il y a quand même un certain nombre de grandes entreprises qui ont des services brevets assez stratégiques.

P.B. : Oui, ça dépend. Je me rappelle un discours de l’agence France Brevets (aujourd’hui disparue) sur le fait qu’il y avait beaucoup d’entreprises en France, même des grandes, dans lesquelles l’évaluation de la politique de propriété intellectuelle se mesurait au poids, c’est-à-dire qu’en fait, elles passaient leur temps à déposer des brevets, parfois sans trop se soucier de leur qualité.

F. L. : Comment les entreprises peuvent-elles utiliser la veille brevet de manière plus stratégique, de façon offensive et défensive ?

P.B. : La première étape serait de reconnaître le brevet non seulement comme un outil de protection juridique, mais également comme une mine d’informations pour l’intelligence économique et concurrentielle. Cela nécessiterait une évolution de la formation et de la sensibilisation sur la valeur et l’utilisation stratégique des brevets.

Le système des brevets repose sur un ensemble complexe de règles juridiques et techniques. Pour pouvoir exploiter efficacement les informations contenues dans les brevets, il est essentiel d’avoir quelques connaissances fondamentales sur le fonctionnement du système des brevets et de comprendre le cadre juridique et technique dans lequel s’inscrit le brevet. Comprendre certains concepts, comme le délai de publication de 18 mois, la notion de revendication, sa différence avec la description, ou encore la distinction entre un brevet en vigueur et une demande de brevet.

Par exemple, il est important de savoir que les brevets sont publiés en deux étapes. Dans un premier temps, le brevet est publié sous forme de demande de brevet, qui contient une description de l’invention, mais ne donne qu’un droit en quelque sorte provisoire. Dans un second temps, le brevet, s’il est délivré, est publié comme tel avec d’éventuelles modifications par rapport à la demande et il donne alors des droits exclusifs sur l’invention.

F. L. : Le système est souvent mal compris. La France devrait-elle s’inspirer d’autres pays, comme la Corée du Sud ou le Japon, pour enseigner la propriété intellectuelle ?

P. B. : Oui, la propriété intellectuelle est un domaine complexe qui mérite d’être enseigné dès le plus jeune âge, comme dans cette série de vidéos. Les Japonais et les Coréens ont mis en place des sites avec des vidéos pour intéresser les élèves à la propriété intellectuelle.

C’est un vrai défi pédagogique, mais cela permettrait aux Français de mieux comprendre les enjeux de la propriété intellectuelle et de mieux exploiter les informations contenues dans les brevets.

Il faudrait s’en inspirer, je pense, ce que l’on sait mal faire en France. Il ne faut surtout pas commencer par l’aspect juridique, mais donner des exemples concrets. En explorant par exemple des bases de données comme Espacenet ou Patentscope pour permettre de voir le brevet « en action » et rendre le sujet plus ludique.

F. L. : Le décalage de 18 mois entre le dépôt d’une demande de brevet et sa publication peut-il limiter l’utilité de la veille brevet pour suivre les innovations de la concurrence ?

P. B. : Trop d’entreprises ignorent même le fait que les brevets sont publiés avec un décalage de 18 mois. Ce décalage n’est pas forcément un obstacle à l’utilisation de la veille brevet, car il est possible de suivre les tendances technologiques à partir des dépôts de brevet.

F. L. : Il y a un autre souci majeur : dans certains secteurs, la quasi-totalité sont des brevets déposés en Chine continentale. Nous sommes submergés par ces brevets, et la plupart ne sont pas étendus en dehors de Chine.

P. B. : C’est effectivement une réalité : dans certains domaines si l’on veut vraiment étudier le sujet, on doit prendre en compte un grand nombre de ces brevets chinois. C’est chronophage et peut être assez ardu, mais au-delà de cet aspect, il est utile de voir ce que font les Chinois d’un point de vue technologique.

Même si une majorité de ces brevets sont déposés localement, 10 à 15 % d’entre eux sont étendus à l’international. Cela représente un volume considérable, deux fois le nombre de demandes de brevets déposés par la France. Et bien qu’il y ait des défis de traduction et de compréhension, il est impératif de ne pas ignorer ces dépôts, car, encore une fois, ils font partie intégrante de l’état de la technique actuelle. Il est essentiel de les examiner, de les traduire et de les comprendre, malgré les limites des outils de traduction actuels.

F. L. : Comment faire ?

P. B. : Il faut vérifier si les brevets ont été étendus à d’autres pays ; et qu’ils aient été étendus ou pas, ils constituent de l’art antérieur. Il faut être vigilant : un brevet chinois, même s’il n’est pas étendu hors de Chine, doit impérativement être pris en compte dans le cadre d’une recherche de nouveauté ou d’activité inventive. Il peut remettre en cause la nouveauté d’une invention faite en France, rendant celle-ci non brevetable.

Même si un brevet déposé uniquement en Chine peut entraver la brevetabilité en France, cela n’empêchera pas d’exploiter librement la technologie ailleurs qu’en Chine donc, en particulier en France (enfin, à condition que d’autres n’aient pas de brevets couvrant en partie cette technologie, la vérification de la liberté d’exploitation n’étant pas un sujet simple).

F. L. : Pour la petite histoire, comment expliquer cette croissance spectaculaire des dépôts de brevets chinois ?

P. B. : Si l’on observe la tendance, cette montée démarre autour de 2005-2006. On note que cela suit l’entrée de la Chine à l’OMC en 2001, ce qui lui a permis de jouir de certains avantages et de mieux exporter ses produits. Peu de temps après, les dépôts de brevets chinois ont commencé à dominer le monde. Actuellement, il y a environ 1 500 000 à 1 600 000 demandes de brevets déposées chaque année à l’Office chinois, contre 400 000 à 500 000 pour les Américains.

C’est une stratégie définie par les autorités chinoises dans les années 2010, qui ont massivement financé les dépôts de brevet des entreprises nationales, sans se préoccuper de la qualité. Le but était d’habituer les entreprises au système de brevetage. Aujourd’hui, tout en conservant ce volume impressionnant, ils se tournent vers une amélioration de la qualité des dépôts.

F. L. : Revenons-en au dispositif brevet des entreprises. Comment ces dernières doivent-elles s’équiper ?

P. B. : En termes d’outils de recherche de brevets, il existe des plateformes gratuites et d’autres qui sont payantes. Les plateformes payantes fonctionnent en général sur la base d’un abonnement annuel dont le montant démarre habituellement à un niveau de 3 500 € HT, mais peut grimper nettement plus haut, ce qui représente un investissement conséquent. De mon point de vue, dès que l’on commence à rechercher régulièrement des informations brevet, disons deux ou trois fois par mois, il est toujours préférable de passer à la version payante, pour plusieurs raisons. On trouve d’abord des fonctionnalités de recherche plus avancées, ainsi que des outils d’analyse statistique. On peut aussi générer des PDF de qualité et des rapports détaillés, ce qui est beaucoup moins faisable sur les plateformes gratuites. Enfin, il y a aussi un service d’assistance technique disponible, ainsi que des formations régulières. En fait, lorsque l’on dépend de l’information brevet pour la veille stratégique dans une entreprise, il est préférable d’utiliser une plateforme payante.

Bien sûr, la version gratuite peut servir d’introduction pour tester les fonctionnalités, mais elle n’offre pas la même palette d’outils. Je recommande donc une version payante pour une utilisation professionnelle.

F. L. : Passons à la stratégie brevets elle-même des entreprises. Comment celles-ci peuvent-elles utiliser les brevets ?

P. B. : Il y a d’abord un piège sémantique à éviter. La stratégie classique de protection des inventions, où l’on dépose un brevet dans le but de pouvoir agir contre quiconque tenterait de s’approprier la technologie brevetée, peut être considérée comme défensive ou offensive, selon les auteurs.

Les deux termes ne sont pas utilisés de la même manière par tout le monde. Certaines personnes considèrent que mettre une barrière autour d’un territoire technologique pour empêcher les autres d’y entrer est une posture défensive. D’autres estiment qu’utiliser un brevet pour attaquer en justice un nouvel entrant dans son territoire technologique est une posture offensive. Il faut donc être prudent, car ces termes ne sont pas toujours clairs.

Cependant, il existe d’autres approches stratégiques des brevets, que certains qualifieraient de détournées, mais que je qualifierais simplement de plus évoluées, ou plus astucieuses. Elles consistent à utiliser les brevets non seulement pour créer une barrière autour d’un territoire technologique, mais aussi pour créer des rapports de force. On peut alors accuser quelqu’un d’entrer dans son territoire technologique, même s’il n’y entre pas réellement. Dans ce cas, la problématique ne sera pas seulement de lutter contre les copieurs, mais aussi d’éviter d’être accusé à tort de copier, ce qui est toujours source de dépenses considérables devant les tribunaux, surtout aux États-Unis.

F. L. : Avez-vous un exemple pour illustrer cette situation problématique ?

P. B. : Un exemple inspiré de faits réels : celui d’une start-up française qui avait une stratégie de brevet classique visant à verrouiller un territoire technologique en France et aux États-Unis. Cependant, après son arrivée aux États-Unis, elle a été accusée d’entrer dans le territoire technologique d’une autre entreprise qui convoitait sa technologie pour se diversifier. Cela a contraint cette start-up à dépenser des millions de dollars pour se défendre en justice. Finalement, devenue exsangue financièrement, elle a accepté d’être rachetée par ce même concurrent américain qui convoitait sa technologie. Cette histoire illustre comment la propriété intellectuelle peut être utilisée non seulement pour protéger les inventions, mais aussi dans une perspective stratégique où elle peut être détournée pour créer des rapports de force et influencer la concurrence. C’est donc aussi une arme économique pour influer sur la concurrence et les marchés.

Les outils de base de la propriété industrielle : brevets, marques, dessins et modèles

Une veille peut s’effectuer sur un très grand nombre de sources telles que les publications dans différents types de presse (généraliste, scientifique…), le web et, en particulier Google ou des sites spécialisés, les réseaux sociaux, les visites de foires et salons, les conférences…

Dans un très grand nombre de cas, particulièrement pour la veille technologique et concurrentielle, il ne faut surtout pas négliger les différentes dimensions de la propriété industrielle : brevets, marques ainsi que dessins et modèles.

Tout d’abord, précisons le vocabulaire, car il y a un fort risque de confusion.

● La propriété industrielle est une de deux composantes de la propriété intellectuelle, l’autre étant la propriété littéraire et artistique.

● La propriété industrielle inclut essentiellement les brevets, les marques et les dessins et modèles, ce à quoi nous allons nous intéresser.

Les bases pour se lancer dans la recherche et la veille brevet

On rappellera en premier lieu qu’un brevet est une sorte de contrat entre l’État en général et un inventeur. En échange de l’exclusivité de l’usage d’une technologie sur une durée pouvant, en général, aller jusqu’à 20 ans, la description de cette technologie est rendue publiquement accessible, après une période de 18 mois, et constitue une information scientifique/technique.

Le titulaire du brevet peut exploiter lui-même sa technologie ou décider s’il autorise un/des tiers à l’exploiter et, dans ce cas, sous quelles conditions (vente du brevet, concession d’une licence).

On entend souvent dire qu’une grande partie des informations techniques (80 % est un chiffre classique) se trouve uniquement dans les brevets et n’est pas disponible dans les articles scientifiques ou les comptes-rendus de congrès. En fait, c’est un peu devenu une « légende urbaine », mais ce chiffre provient d’une étude publiée en… 1977 aux États-Unis, menée avec une rigueur très relative et alors que le paysage a énormément changé en plus de 45 ans. Pratiquement jamais sourcé, bien que trouvé des millions de fois par Google, ce chiffre sert surtout à faire la promotion de l’utilisation des brevets.

Les critères de brevetabilité

Pour être brevetable, l’invention doit respecter plusieurs critères :

- La nouveauté : il s’agit d’une nouveauté « absolue ». L’invention ne doit jamais avoir été rendue accessible au public sous quelque forme que ce soit. Une « publication antérieure » peut être un brevet, mais pas nécessairement. Il peut également s’agir d’un article publié dans une revue scientifique. Cette antériorité peut aussi être trouvée dans une publication à petit tirage, récente ou non, mais réellement diffusée en France ou ailleurs dans le monde. Cela peut même être une bande dessinée ;

- L’activité inventive : l’invention ne doit pas découler de manière évidente de la technique connue par « l’homme de métier » ;

- L’application industrielle : l’invention doit pouvoir être fabriquée ou utilisée, quel que soit le type d’industrie.

Un brevet est déposé dans un ou plusieurs pays et, s’il est délivré, n’exerce ses effets que dans ce(s) pays. Cela signifie que la technologie qu’il décrit peut-être librement utilisée dans les autres pays, mais ne pourra évidemment pas faire l’objet d’autre brevet dans ces pays. Il existe des dépôts dans un pays, mais il existe aussi des dépôts multi pays : les brevets PCT (Patent Cooperation Treaty), les brevets européens et depuis peu les brevets unitaires, ces derniers couvrant 17 États membres de l’Union européenne.

Il faut être attentif au fait qu’une demande de brevet n’est publiée que dix-huit mois après son dépôt, mais cette publication ne veut en aucun cas dire que le brevet sera délivré. Cependant, le contenu de cette demande constituera ce que l’on appelle un art antérieur.

Déjà abonné ? Connectez-vous...

Connexion

Les Tags de Netsources

- IA

- brevets

- cartographie

- SEO

- open access

- livrables de veille

- humain

- médias sociaux

- sourcing veille

- flux RSS

- professionnel de l'information

- open data

- recherche vocale

- information business

- agrégateurs de presse

- à lire

- conférences salons

- information scientifique et technique

- outils de recherche

- outils de veille

- tendances

- multimédia

- actualités

- méthodologie

- serveur de bases de données

- curation

- due diligence

- recherche visuelle

- outils de traduction

- fake news

- fact checking

- publicité

- géolocalisation

- marques

- appels d'offres

- sommaire

- formation Veille Infodoc

- retour d'expérience

- OSINT

- propriété intellectuelle

- presse en ligne

- recherche Web

- évaluation outils

- références bibliographiques

- résumé automatique

- Bing

- veille collaborative

- veille audiovisuelle

- veille innovation

- infobésité

- études de marché

- données statistiques

- dataviz

- information financière

- LexisNexis

- Newsdesk

- sourcing pays

- veille medias

- veille commerciale

- réseaux sociaux

- newsletter

- veille à l'International

- ist

- ChatGPT

- veille métier

- intelligence économique

- veille concurrentielle

- podcast

- science ouverte

- open source

- veille technologique

- knowledge management

- édito

- Intelligence artificielle

- navigateur IA

- sécurité informatique

- navigateur agentique