Dans ce numéro, nous publions la première partie d’un dossier complet consacré au prompt engineering. La seconde partie paraîtra dans le prochain numéro de NETSOURCES

Ce dossier a pour objectif de vous accompagner dans la maîtrise du prompt engineering, discipline clé pour exploiter pleinement le potentiel des modèles de langage.

De la compréhension des mécanismes fondamentaux aux techniques les plus avancées, , ces deux articles constituent un guide complet pour maîtriser l’art du prompt engineering et tirer le meilleur parti des modèles de langage actuels et futurs.

Premier article : les fondamentaux du prompt engineering

Ce premier article récapitule les principes essentiels pour optimiser la formulation des prompts:

- Mécanismes internes des LLM : Rappel des processus clés - tokenisation (découpage du texte), embeddings vectoriels (représentation numérique) et architecture transformer (mécanismes d’attention) - pour comprendre comment les modèles traitent les prompts).

- Frameworks de structuration : Présentation de méthodologies structurantes combinant contexte, rôle et format de sortie, illustrées par des exemples concrets d’application.

- Techniques avancées : Exploration de méthodes sophistiquées comme les chaînes de pensées, ainsi que des techniques parfois méconnues comme l’utilisation de délimiteurs.

- Stratégie de longueur : Faut-il privilégier un prompt long et complet («méga-prompt») ou procéder par itérations successives ? La longueur optimale du prompt est une question cruciale.

-

Vous êtes ici :

- Accueil

- Publications

- Netsources

Les articles de Netsources

Maîtriser l’IA, un art au service de l’intelligence humaine

L’intelligence artificielle générative n’est pas qu’un outil de productivité : elle redéfinit notre manière de penser, de créer et d’interagir avec l’information. Elle peut devenir une alliée puissante, à condition de l’aborder comme un levier d’amplification de l’intelligence humaine plutôt qu’un substitut.

Ce nouveau numéro de Netsources explore cette ambition à travers quatre dimensions : la maîtrise du dialogue avec le modèle IA, l’évaluation critique des innovations, la création multimédia et plus essentielle que jamais, la préservation de nos capacités intellectuelles.

D’abord, l’art du dialogue avec l’IA. Véronique Mesguich (« Le prompt, un art pour la veille stratégique et la recherche d’information »), montre que le prompt engineering dépasse la simple formulation technique : c’est une discipline de précision, qui fait du professionnel un véritable architecte de requêtes, capables d’augmenter significativement la performance des résultats générés par les LLM.

La mise à l’épreuve des outils illustre cette exigence. Dans son analyse (« ChatGPT Agent : un collaborateur virtuel pour les professionnels de l’information ? »), Ulysse Rajim teste l’agent autonome d’OpenAI sur des tâches comme l’analyse concurrentielle, l’audit SEO ou le social listening. Impressionnant par sa rapidité, l’outil révèle aussi ses limites : erreurs factuelles, accès bloqué par des paywalls, incertitudes liées à la confidentialité des données.

Le prompt, un art pour la veille stratégique et la recherche d’information (1ere partie)

Test complet de ChatGPT Agent : que vaut-il pour la veille, l'analyse concurrentielle et l'audit SEO ?

ChatGPT Agent promet de révolutionner l'automatisation des tâches professionnelles. Recherche intelligente, navigation autonome, exécution complète de missions complexes : marketing ou réalité ? Nous avons testé l'outil en conditions réelles sur trois métiers critiques de l'information. Notre verdict sans concession.

Avec le lancement de sa nouvelle fonctionnalité Agent, OpenAI enrichit ChatGPT de nouvelles capacités. En plus des échanges conversationnels, l’outil peut désormais exécuter des tâches complexes en combinant recherche avancée et actions autonomes dans un navigateur. C’est en tout cas la promesse : fusionner les capacités d’analyse de Deep Research et d’action d’Operator pour créer un assistant capable de prendre en charge une tâche de A à Z.

Pour évaluer les capacités réelles de cet agent dans un contexte professionnel, nous l’avons mis à l’épreuve à travers trois cas d’usage concrets : une analyse concurrentielle, un audit SEO et une étude de social listening.

I. Présentation de ChatGPT Agent

Annoncée le 17 juillet 2025, la fonctionnalité Agent de ChatGPT est disponible en France depuis le 8 août pour les abonnés aux forfaits Plus, Pro et Team. Elle est issue de la fusion de deux technologies qu’OpenAI développait en parallèle : d’une part, Deep Research, un système de recherche approfondie capable de parcourir des centaines de sources pour synthétiser des sujets complexes, et d’autre part, Operator, un agent capable de prendre le contrôle d’un navigateur web pour effectuer des actions comme cliquer sur des liens ou remplir des formulaires. En combinant les deux, ChatGPT Agent vise à permettre de déléguer à l’IA des activités plus complexes.

Optimiser son podcast spécialisé avec l’intelligence artificielle : mode d’emploi

Monter un podcast ne se fait pas en un claquement de doigts. De la préparation des épisodes à leur diffusion, l’intelligence artificielle peut devenir un allié précieux. Voici comment l’utiliser pour gagner du temps, améliorer la qualité sonore et élargir votre audience.

Lancer un podcast spécialisé, entre nous, ce n’est pas toujours facile. Il faut : trouver une niche, construire un ton, fidéliser une communauté autour d’un sujet précis. Mais comment passer au niveau supérieur quand on n’a ni une équipe de production hollywoodienne ni des journées de 48 heures ? Bonne nouvelle : l’intelligence artificielle générative (IAG) s’invite aujourd’hui dans la boîte à outils des podcasteurs et peut transformer la préparation, la production et la diffusion de votre émission.

Voici un guide pratique pour optimiser son podcast grâce à l’IA, sans aucun effort !

L’IA pour préparer et structurer ses épisodes

La première étape d’un podcast, c’est la matière première : les idées. L’IA peut ici devenir un véritable assistant éditorial.

- Recherche documentaire : plus besoin de passer des heures à compiler articles et études. Des outils comme Perplexity AI ou ChatGPT vous aident à synthétiser des sources fiables, résumer des textes longs et dégager des tendances.

- Plan d’épisode : vous manquez d’inspiration ? L’IA génère des trames d’interview, propose des questions pertinentes pour vos invités et suggère des angles auxquels vous n’auriez pas pensé.

- Storyboard audio : certaines solutions, comme Notion AI ou Mem, aident à structurer vos notes et à transformer une idée brute en plan clair et hiérarchisé.

Penser par soi-même - êtes-vous « IA Gen sobre » ?

Chroniques amusées sur l’intelligence artificielle par Christian Vigne Christian VIGNE

Christian Vigne, anciennement Product Manager chez Google, s’amuse dans ses chroniques à explorer l’impact de l’IA sur nos vies. Il est amené à conseiller les entreprises sur leurs stratégies IA (cadrage, priorisation, formation, conduite du changement).

J’ai découvert Luc Julia grâce à l’excellente série d’Arte intitulée « Silicon Fucking Valley ». Luc Julia est directeur scientifique, co-inventeur de Siri, et tellement français à bien des égards. Son dernier livre, IA génératives, pas créatives — l’intelligence artificielle n’existe (toujours) pas, agit comme une douche glacée pour obliger à reconsidérer l’engouement autour de l’IA générative. Je suis tombé sur un parallèle intéressant (page 168) entre les déplacements « auto-propulsés » et la pensée « auto-propulsée ». L’idée : demain, on nous demandera de faire un usage raisonné de l’IA générative (car elle consomme énormément de ressources) de la même manière qu’on nous demande aujourd’hui d’utiliser nos voitures avec parcimonie (car elles nuisent à l’environnement).

IA générative : l’humain ne doit pas dire son dernier mot

Imaginez un monde où l’intelligence artificielle générative deviendrait un documentaliste chevronné pour orchestrer vos recherches les plus ardues, un allié incontournable dans toutes vos tâches de traitement et de gestion de l’information, un compagnon d’une humanité confondante sur les réseaux sociaux, - un monde où rédiger une lettre de motivation sans IA s’imposerait comme un acte d’authenticité revendiqué…

Ce monde est déjà le nôtre. À la lecture de ce Netsources, on mesure l’ampleur avec laquelle l’IAG s’est infiltrée dans chaque facette de nos activités intellectuelles .

Dans son « Guide pratique du Deep Research », Véronique Mesguich montre comment l’IA est particulièrement intéressante dans le cas de recherches complexes exigeant l’analyse de sources multiples, et de production de synthèses, redéfinissant — ce faisant — le rôle des experts.

Ulysse Rajim (« Quand l’IA réinvente les réseaux sociaux… ») décrypte comment l’IA redéfinit les interactions sur les réseaux sociaux, complexifie la veille en brouillant l’authenticité de la parole et convertit les plateformes en viviers de données pour nourrir leur apprentissage.

Le guide pratique du Deep Research

Dans le précédent numéro de Netsources (« Deep Research : l’âge de raison des IA ? », Netsources N° 175 - mars/avril 2025), nous avons décrit et analysé l’irruption et les nombreux développements des outils de Deep Research proposés par les différentes IA.

Passons dans cette deuxième partie à la pratique en présentant et comparant les résultats obtenus avec les différents outils.

Une recherche approfondie pas à pas

Testons à présent la recherche approfondie des IA sur un exemple, en partant du prompt suivant : « Comporte-toi comme un analyste veilleur et rédige un rapport détaillé sur la stratégie et le positionnement des entreprises françaises dans le contexte des droits de douane annoncés par Trump en 2025. Base-toi sur des exemples concrets d’entreprises françaises dans différents secteurs (luxe, automobile, vins et spiritueux) pour étudier et comparer les différents positionnements et stratégies ».

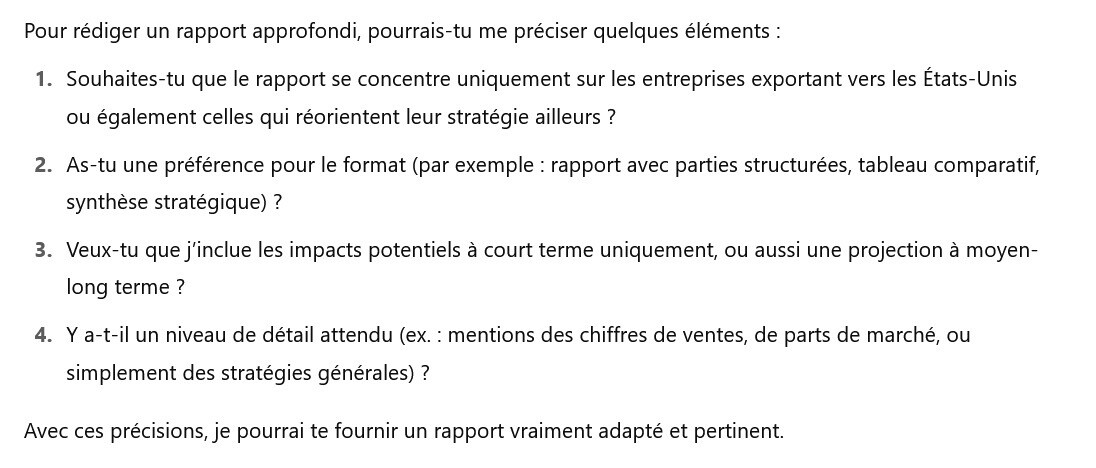

Commençons par la recherche approfondie de ChatGPT (disponible dans la version payante, et depuis peu, de façon limitée dans la version gratuite). Avant d’élaborer son plan de veille, l’IA demande des précisions :

Une fois les précisions apportées par l’utilisateur, l’IA récapitule la demande et élabore son plan de recherche.

Quand l’IA réinvente les réseaux sociaux : décryptage d’une mutation

L’intégration de l’intelligence artificielle dans les réseaux sociaux est une tendance de fond, entamée au début des années 2010 et qui connaît une accélération marquée depuis l’émergence de l’IA générative en fin 2022. Cette évolution redéfinit l’utilité de ces plateformes, leur modèle économique et la nature même des interactions qu’elles hébergent.

Nous explorerons comment l’IA est passée d’un outil d’optimisation fonctionnant en arrière-plan à un rôle de plus en plus central dans nos échanges. Ce changement soulève une question essentielle : à mesure que l’IA prend plus de place, que reste-t-il de « social » dans les médias sociaux et comment cela impacte-t-il nos interactions en ligne ?

I. L’IA en coulisses : l’optimisation comme premier moteur

Pendant plus d’une décennie, l’intelligence artificielle a été le moteur discret, mais essentiel, des réseaux sociaux. Son déploiement à grande échelle répondait à un objectif principal : capter l’attention de l’utilisateur pour maximiser la durée des sessions et, par conséquent, les revenus publicitaires.

La fin du fil d’actualité chronologique

Cette stratégie reposait sur la personnalisation des contenus . Dès 2009, Facebook expérimentait déjà un nouvel algorithme (nommé EdgeRank ) pour remplacer le fil d’actualité chronologique (1). C’est entre 2012 et 2016 que cette tendance se généralise. Durant cette période, la plupart des plateformes de réseaux sociaux abandonnent progressivement le fil chronologique au profit du fil algorithmique . L’objectif n’étant alors plus de montrer ce qui venait d’être publié, mais ce qui était le plus susceptible de provoquer une réaction . Twitter remplace ainsi son fil d’actualité par le flux « Home timeline » en 2016 (2), et TikTok, lancé une année plus tard, érige cette approche en modèle avec sa « For You Page » (3). Aujourd’hui, cette méthode est devenue la norme et les algorithmes n’ont fait que s’améliorer d’année en année. Meta annonçait d’ailleurs en 2023 que ses algorithmes de recommandation étaient responsables d’une hausse de 24 % du temps passé sur Instagram , notamment grâce à la suggestion de contenus issus de comptes non suivis par les utilisateurs (4).

L’impact de l’intelligence artificielle générative sur les métiers de l’information-documentation : entretien avec Christophe Deschamps

Nous avons souhaité interroger Christophe afin qu’il partage ses observations sur les transformations apportées par l’intelligence artificielle générative. Cet entretien apporte un éclairage sur l’évolution de la veille et du Knowledge Management à l’ère de l’IA.

Christophe Deschamps est depuis 20 ans consultant‐formateur en veille stratégique, intelligence économique et gestion des connaissances. Il enseigne depuis plusieurs années ces matières à l’IAE de Poitiers, à l’ILERI et à OTERIA Cyber School. Il publie régulièrement dans des revues comme Archimag, ou I2D (anciennement Documentaliste - Sciences de l’information). Il est l’auteur de plusieurs ouvrages sur l’intelligence économique et la veille, dont La boîte à outils de l’intelligence économique (Dunod), et l’animateur du blog OUTILS FROIDS .

CHRISTEL RONSIN : Christophe, depuis quand vous intéressez-vous au phénomène de l’intelligence artificielle générative ?

CHRISTOPHE DESCHAMPS : Mon intérêt pour l’intelligence artificielle générative a commencé vers 2017-2018, avec l’émergence des deepfakes . L’une des vidéos les plus marquantes était celle d’Obama, où il était presque impossible de distinguer la vidéo truquée de la réalité. Le mouvement de ses lèvres avait été modifié par l’IA pour lui faire dire des phrases qu’il n’avait jamais prononcées. Cela a naturellement suscité mon intérêt, car ce que redoutent le plus les professionnels de l’information, c'est évidemment de se faire manipuler par de fausses images, vidéos ou textes.

« Love your imperfections »

Chroniques amusées sur l’intelligence artificielle par Christian Vigne

Christian Vigne, anciennement Product Manager chez Google, s’amuse dans ses chroniques à explorer l’impact de l’IA sur nos vies. Il est amené à conseiller les entreprises sur leurs stratégies IA (cadrage, priorisation, formation, conduite du changement).

Pour ceux qui ne connaissent pas, Meetic est une application/service de rencontre français qui a lancé en 2014 une campagne de marque, brillante selon moi, intitulée « aimez vos imperfections ». Dans la publicité, une série de scènes montre des personnes en rendez-vous amoureux confrontées à leurs propres imperfections : arriver en retard, ne pas être assez fort, faire des mouvements étranges et ridicules en dansant. Chaque comportement est perçu à travers les yeux de l’autre personne, qui interprète ces imperfections comme des choses touchantes : « Tu cours parce que tu es impatient de me voir, pas parce que tu es en retard. Tu ne montres pas ta force pour me laisser gagner. J’adore ta façon de danser, aussi étrange soit-elle… »

J’ai récemment postulé à un emploi dans une des grandes entreprises spécialisées en IA générative. Oui, je sais, c’est comme essayer de séduire la fille (ou le garçon) la plus attirant(e) de la fête quand tout le monde tente sa chance. Mais qui sait, sur un malentendu… Ce qui m’a frappé en postulant, c’est que cette entreprise, qui développe des modèles d’IA générative de pointe mondialement reconnus, précisait explicitement dans son processus de candidature qu’il ne fallait pas utiliser leurs services ni ceux de leurs concurrents pour préparer la candidature, particulièrement la lettre de motivation. La note indiquait : « Nous souhaitons comprendre votre intérêt personnel pour (XX) sans médiation par un système d’IA, et évaluer également vos compétences en communication non assistée par IA. » Ironique, non ? C’est comme s’ils disaient : « Merci de ne pas utiliser la technologie créée par l’entreprise pour laquelle vous postulez. »

Les Tags de Netsources

- IA

- brevets

- cartographie

- SEO

- open access

- livrables de veille

- humain

- médias sociaux

- sourcing veille

- flux RSS

- professionnel de l'information

- open data

- recherche vocale

- information business

- agrégateurs de presse

- à lire

- conférences salons

- information scientifique et technique

- outils de recherche

- outils de veille

- tendances

- multimédia

- actualités

- méthodologie

- serveur de bases de données

- curation

- due diligence

- recherche visuelle

- outils de traduction

- fake news

- fact checking

- publicité

- géolocalisation

- marques

- appels d'offres

- sommaire

- formation Veille Infodoc

- retour d'expérience

- OSINT

- propriété intellectuelle

- presse en ligne

- recherche Web

- évaluation outils

- références bibliographiques

- résumé automatique

- Bing

- veille collaborative

- veille audiovisuelle

- veille innovation

- infobésité

- études de marché

- données statistiques

- dataviz

- information financière

- LexisNexis

- Newsdesk

- sourcing pays

- veille medias

- veille commerciale

- réseaux sociaux

- newsletter

- veille à l'International

- ist

- ChatGPT

- veille métier

- intelligence économique

- veille concurrentielle

- podcast

- science ouverte

- open source

- veille technologique

- knowledge management

- édito

- Intelligence artificielle

- navigateur IA

- sécurité informatique

- navigateur agentique

- méthodologie et livrables