Le SEO (Search Engine Optimisation) participe à l’accès à la connaissance, en influençant directement la manière dont l’information est indexée, trouvée, hiérarchisée et diffusée sur le web.

Cependant, à l’heure où les robots conversationnels sont de plus en plus capables d’effectuer des recherches et synthèses de pages web, les créateurs de contenus web se voient confrontés à la nécessité de réévaluer leurs stratégies de référencement : il s’agit en effet de rendre les contenus visibles dans ce nouvel environnement aussi mouvant que concurrentiel.

Les professionnels de l’information (au sens large du terme) sont également concernés, et doivent adapter leurs stratégies de recherche à cette période de transition où les critères de visibilité des contenus sur le web se complexifient.

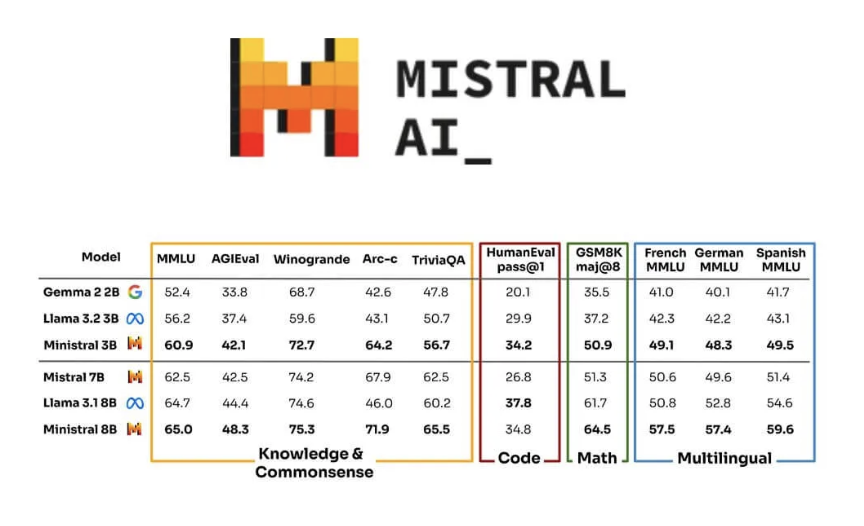

Ce bouleversement pose de nombreuses questions : comment les sites web peuvent-ils maintenir, voire améliorer leur visibilité lorsque les internautes ne recherchent plus uniquement via les moteurs classiques comme Google ou Bing, mais interagissent avec des IA conversationnelles telles que ChatGPT, Mistral ou DeepSeek ? Comment optimiser le contenu pour être « consulté » et relayé par des chatbots qui se comportent de plus en plus comme des agents autonomes ?

L’avenir du SEO (Search Engine Optimization, ou référencement naturel) se résume souvent à la chronique d’une mort annoncée, et ce, depuis plusieurs années. Et pourtant, la pratique du SEO reste indispensable, pour optimiser la visibilité des contenus, non seulement via les résultats du moteur Google, mais aussi dans un environnement multiplateforme incluant notamment des réseaux comme TikTok.

Ce contexte dynamique nous invite à explorer l’impact des IA génératives sur les stratégies SEO et à découvrir l’émergence d’une nouvelle tendance : le GEO ou Generative Engine Optimisation.

Une pratique du SEO en constante évolution

La pratique du SEO n’a en fait cessé d’évoluer, depuis son apparition dès le milieu des années 90. Mais c’est surtout au début des années 2000 que la discipline du SEO a pris son essor, en lien avec la domination croissante de Google et l’évolution de ses algorithmes. Au début des années 2010, des mises à jour telles que Panda ou Penguin ont modifié les critères de classement en favorisant la qualité du contenu et la pertinence des résultats de recherche ; la mise à jour Hummingbird, en 2013, introduit et améliore la compréhension sémantique des requêtes. Plus récemment, un nouveau tournant est engagé avec des algorithmes d’intelligence artificielle. Il s’agit des modèles de langage BERT, élaboré en 2018, et utilisant comme GPT la technologie des transformers, et MUM (le Multitask Unified Model) apparu en 2021. L’objectif est de mieux comprendre les requêtes complexes des utilisateurs à travers notamment des mécanismes d’attention.

L’expérience utilisateur est devenue également un critère important pour le référencement et le classement des sites web. Les moteurs de recherche privilégient désormais les sites offrant une navigation fluide, une compatibilité mobile optimale et des temps de chargement rapides, à travers des indicateurs tels que les Core Web Vitals déployés par Google en 2021. La mise à jour de 2023 « Helpful Content Update » ou HCU s’inscrit également dans une stratégie de valorisation des contenus censés apporter une valeur ajoutée aux utilisateurs. HCU vient ainsi compléter les critères EEAT (Expérience, Expertise, Autorité et Confiance) destinés à évaluer la crédibilité d’un site ou d’un contenu.

Google, à l’instar des géants du numérique, reste peu transparent sur le fonctionnement de ses algorithmes ! En revanche, en 2024, une fuite de documents internes (les fameux « Google Leaks ») a révélé des informations détaillées sur le fonctionnement de son algorithme de recherche, confirmant des hypothèses formulées par les spécialistes du SEO. Ces révélations soulignent l’importance de créer un contenu de haute qualité, d’obtenir des liens pertinents et de fournir une expérience utilisateur optimale pour améliorer le classement dans les résultats de recherche de Google.

Dans les premières années, le SEO s’est ainsi concentré sur des pratiques telles que le choix de mots-clés, la construction de backlinks et l’optimisation des méta descriptions. Aujourd’hui, l’enjeu pour les créateurs de contenus est de produire des contenus capables d’être contextualisés et interprétés par les algorithmes des chatbots.

Le moteur Google est-il toujours un passage obligé pour la recherche d’informations ?

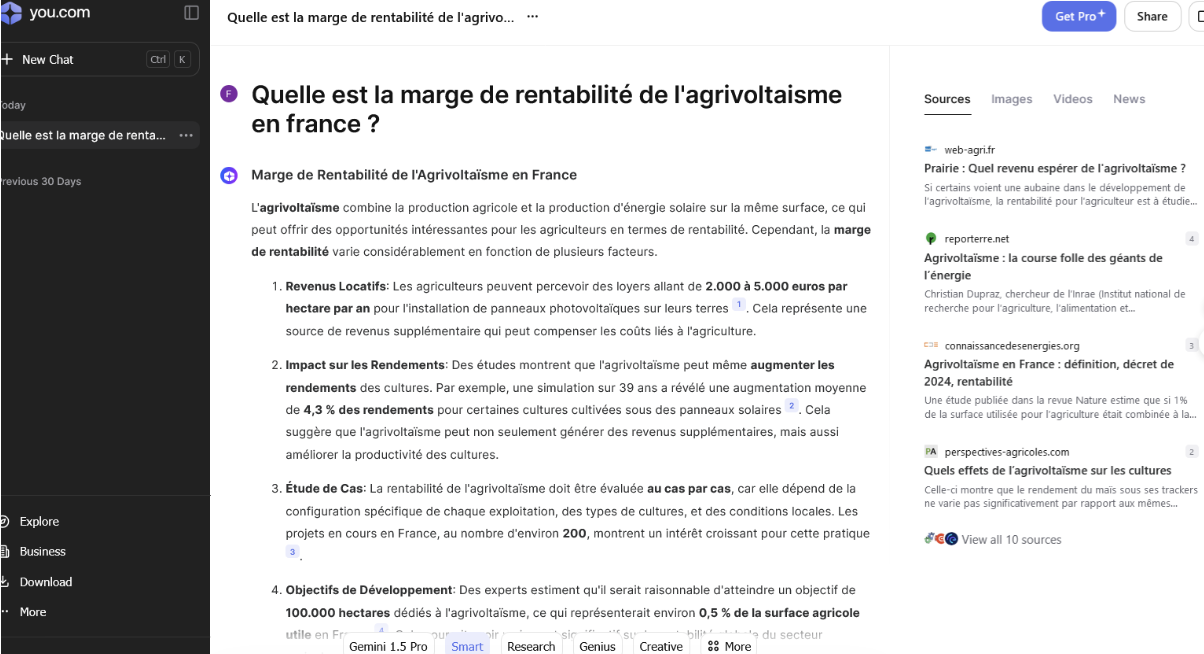

Une enquête menée en septembre 2024 par le site The Information (spécialisé dans les nouvelles technologies) auprès de 1 088 abonnés révèle que 77 % des participants utilisent des IA génératives, plutôt que Google pour certaines requêtes. Ce chiffre souligne une adoption croissante de ces nouvelles technologies, impactant l’usage des moteurs de recherche traditionnels.

Toutefois, un sondage réalisé sur X également en fin 2024 par le journaliste Barry Schwartz (spécialiste du SEO et rédacteur en chef du Search Engine Roundtable) auprès de 917 votants donne un résultat plus nuancé : 55 % des répondants indiquent privilégier l’IA générative à Google Search. En France, une étude IPSOS publiée en février 2025 révèle que 39 % des sondés utilisent des IA génératives pour diverses tâches, dont 48% pour des recherches d’informations.

Ces différences dans les données chiffrées suggèrent que l’ampleur du phénomène peut varier en fonction des répondants, de leurs profils et du type de recherches effectuées.